Routing in einem Cluster

Das Routing in einem Cluster funktioniert ähnlich wie das Routing in einem eigenständigen System. Ein paar Punkte, die es zu beachten gilt:

-

Alle Routing-Konfigurationen müssen von der Cluster-IP-Adresse aus durchgeführt werden, und die Konfigurationen werden an die anderen Clusterknoten weitergegeben.

-

Routen sind auf die maximale Anzahl von ECMP-Routen begrenzt, die vom Upstream-Router unterstützt werden.

-

Knotenspezifische Routing-Konfigurationen müssen mit dem Argument owner-node wie folgt durchgeführt werden:

router ospf

owner-node 0

ospf router-id 97.131.0.1

exit-owner-node

!

<!--NeedCopy-->

Der folgende Befehl zeigt die konsolidierte Clusterkonfiguration für alle Knoten in VTYSH an.

show cluster-config

Der folgende Befehl zeigt den Clusterstatus auf jedem Knoten an.

show cluser node

IPv4-Routing im L2-Cluster

Der folgende Abschnitt enthält Beispielkonfigurationen, die Ihnen bei der Konfiguration von IPv4-OSPF- und BGP-Routing im L2-Cluster helfen.

Hinzufügen einer erkannten SNIP-Adresse und Aktivieren von dynamischem Routing

In der folgenden Konfiguration sind OSPF- und BGP-Routing aktiviert. Außerdem werden entdeckte SNIP-Adressen hinzugefügt und dynamisches Routing ist für diese SNIP-Adressen aktiviert.

en ns fea ospf bgp

add vlan 10

add ns ip 10.10.10.1 255.255.255.0 -dynamicrouting enabled -ownernode 1

add ns ip 10.10.10.2 255.255.255.0 -dynamicrouting enabled -ownernode 2

add ns ip 10.10.10.3 255.255.255.0 -dynamicrouting enabled -ownernode 3

bind vlan 10 -ipaddress 10.10.10.1 255.255.255.0

<!--NeedCopy-->

VTYSH IPv4-OSPF-Konfiguration

Um IPv4-OSPF im L2-Cluster zu konfigurieren, müssen Sie:

- Setzen Sie die Priorität auf Null.

- Konfigurieren Sie die Router-ID als Spott-Konfiguration.

Hinweis

Die OSPF-Konfigurationsrichtlinien für den L2-Cluster gelten auch für OSPFv3.

In der folgenden Beispielkonfiguration ist IPv4 OSPF konfiguriert.

interface vlan10

IP OSPF PRIORITY 0

!

router ospf

owner-node 1

ospf router-id 97.131.0.1

exit-owner-node

owner-node 2

ospf router-id 97.131.0.2

exit-owner-node

owner-node 3

ospf router-id 97.131.0.3

exit-owner-node

network 10.10.10.0/24 area 0

redistribute kernel

!

<!--NeedCopy-->

VTYSH IPv4-BGP-Konfiguration

In der folgenden VTYSH-Beispielkonfiguration ist IPv4-BGP konfiguriert.

router bgp 100

neighbor 10.10.10.10 remote-as 200

owner-node 1

neighbor 10.10.10.10 update-source 10.10.10.1

exit-owner-node

owner-node 2

neighbor 10.10.10.10 update-source 10.10.10.2

exit-owner-node

owner-node 3

neighbor 10.10.10.10 update-source 10.10.10.3

exit-owner-node

redistribute kernel

!

<!--NeedCopy-->

Hinweis

Der Befehl update-source wird für jeden Nachbarn mit dem Argument owner-node in der folgenden Konfiguration verwendet, um eine Verbindung mit der richtigen Quell-IP herzustellen.

IPv6-Routing im L2-Cluster

Der folgende Abschnitt enthält Beispielkonfigurationen, die Ihnen bei der Konfiguration von IPv6-OSPF- und BGP-Routing im L2-Cluster helfen.

IPv6-Routing aktivieren

Bevor Sie IPv6-Routing in einem L2-Cluster konfigurieren, müssen Sie die IPv6-Funktion aktivieren.

Um IPv6-Routing mithilfe der CLI zu aktivieren,

Geben Sie in der Befehlszeile Folgendes ein:

enable ns fea ipv6pt

Hinzufügen einer erkannten SNIP6-Adresse und Aktivieren von dynamischem Routing

In der folgenden Konfiguration sind OSPF- und BGP-Routing aktiviert. Außerdem werden entdeckte SNIP6-Adressen hinzugefügt und dynamisches Routing ist für diese SNIP6-Adressen aktiviert.

add ns ip6 3ffa::1/64 -dynamicrouting enabled -ownernode 1

add ns ip6 3ffa::2/64 -dynamicrouting enabled -ownernode 2

add ns ip6 3ffa::3/64 -dynamicrouting enabled -ownernode 3

add vlan 10

bind vlan 10 -ipaddress 3ffa::1/64

<!--NeedCopy-->

VTYSH IPv6-BGP-Konfiguration

In der folgenden VTYSH-Beispielkonfiguration ist IPv6-BGP konfiguriert.

router bgp 100

neighbor 3ffa::10 remote-as 200

owner-node 1

neighbor 3ffa::10 update-source 3ffa::1

exit-owner-node

owner-node-2

neighbor 3ffa::10 update-source 3ffa::2

exit-owner-node

owner-node-3

neighbor 3ffa::10 update-source 3ffa::3

exit-owner-node

no neighbor 3ffa::10 activate

address-family ipv6

redistribute kernel

neighbor 3ffa::10 activate

exit-address-family

!

<!--NeedCopy-->

Gelernte IPv6-Routen installieren

Der NetScaler-Cluster kann Routen verwenden, die von verschiedenen Routing-Protokollen gelernt wurden, nachdem Sie die Routen in der NetScaler-Cluster-Routingtabelle installiert haben.

Gehen Sie wie folgt vor, um erlernte IPv6-Routen in die interne Routingtabelle mithilfe der CLI zu installieren:

Geben Sie in der Befehlszeile Folgendes ein:

-

ns route-install ipv6 bgp -

ns route-install ipv6 ospf -

ns route-install default

Hinweis

Wenn Sie IPv4-Routen auf einem IPv6-Nachbarn austauschen müssen, müssen Sie den Befehl

no neighbor 3ffa::10 activeVTYSH aus der früheren Konfiguration entfernen.Der

update-sourceVTYSH-Befehl muss für jeden Besitzerknoten verwendet werden, um die richtige IPv6-Quell-IP anzugeben, während eine Verbindung zum BGP-Peer hergestellt wird, wie in der BGP-IPv4-Konfiguration angegeben.

Routing in einem L3-Cluster

Das Routing in einem L3-Cluster funktioniert nur, wenn die folgenden Konfigurationen auf der NetScaler-Appliance vorgenommen wurden.

-

Aktivieren Sie das dynamische Routing für ein VLAN.

set vlan <id> -dynamicrouting enabled <!--NeedCopy--> -

Um alle Clusterknoten zu erreichen, müssen VIP-, CLIP- und NetScaler-IP (NSIP) zusammen mit dem Befehl über Routing-Protokolle angekündigt werden.

set vlan

Bereitstellungsszenario für BGP im L3-Cluster

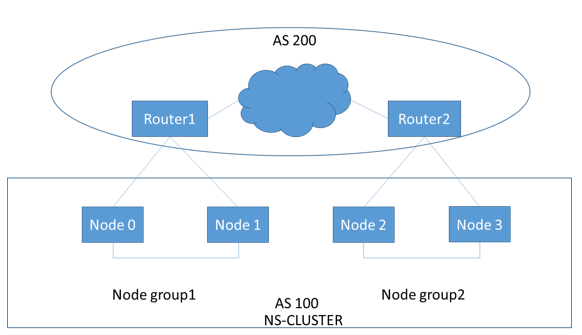

Stellen Sie sich ein Beispiel vor, in dem alle Clusterknoten im AS 100-Netzwerk gruppiert sind und sich die Upstream-Router in einem anderen AS 200-Netzwerk befinden.

Die folgende Abbildung zeigt die AS 100- und AS 200-Bereitstellung in einem Cluster-Setup.

Bei dieser Bereitstellung kündigt CLIP den Upstream-Routern CCO an. Einige Clusterknoten unterbrechen den angekündigten Datenverkehr, da eine AS-Loop erkannt wird.

Um das Problem zu beheben, konfigurieren Sie den folgenden Befehl im VTYSH BGP-Router-Modus für jeden Nachbarn.

Geben Sie in der VTYSH-Befehlszeile Folgendes ein:

neighbor <peer_ip> allowas-in 1

Als bewährte Methode empfiehlt Citrix, eine der folgenden Optionen zu konfigurieren:

-

Konfigurieren Sie Route-Maps, um nur die gewünschten Netzwerke zu ermitteln, z. B. Standardroute, NetScaler IP (NSIP) und NSIP-Subnetze auf Clusterknoten.

-

Konfigurieren Sie Upstream-Routen, um nur gewünschte Netzwerke wie CLIP und NetScaler IP (NSIP) im Cluster anzukündigen.