Escalabilidad

Dado que la optimización de TCP consume muchos recursos, es posible que un solo dispositivo NetScaler, incluso un dispositivo de gama alta, no pueda mantener un alto rendimiento de GI-LAN. Para ampliar la capacidad de su red, puede implementar dispositivos NetScaler en forma de clústeres N+1. En una implementación de clúster, los dispositivos NetScaler funcionan juntos como una sola imagen del sistema. El tráfico del cliente se distribuye entre los nodos del clúster con la ayuda de un dispositivo conmutador externo.

Topología

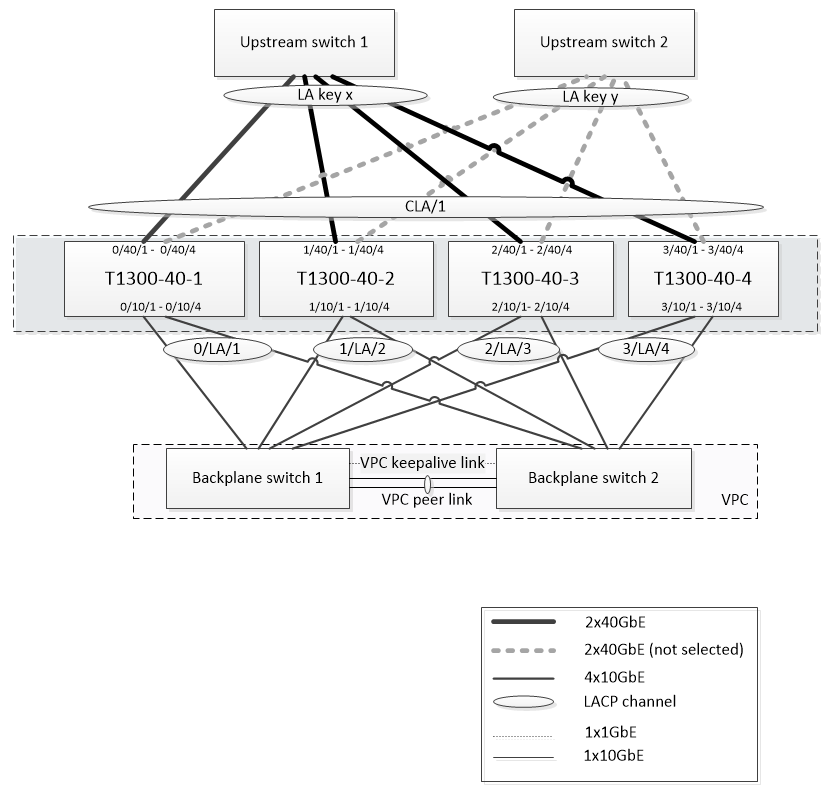

La ilustración 1 es un ejemplo de un clúster que consta de cuatro nodos T1300-40G.

La configuración que se muestra en la figura 1 tiene las siguientes propiedades:

- Todos los nodos del clúster pertenecen a la misma red (también conocida como clúster L2).

- El tráfico del plano de datos y de la placa base se gestiona mediante diferentes conmutadores.

- Suponiendo que el rendimiento de la Gi-LAN sea de 200 Gbps y que un dispositivo T1300-40G pueda mantener un rendimiento de 80 Gbps, necesitamos tres dispositivos T1300-40G. Para proporcionar redundancia en caso de que se produzca un error en un solo nodo del clúster, implementamos cuatro dispositivos en total.

- Cada nodo recibirá hasta 67 Gbps de tráfico (50 Gbps en condiciones de funcionamiento normales y 67 Gbps en caso de fallo en un nodo de un clúster), por lo que necesita conexiones de 2 x 40 Gbps al conmutador ascendente. Para proporcionar redundancia en caso de fallo del conmutador, implementamos un par de conmutadores ascendentes y duplicamos el número de conexiones.

- La agregación de enlaces de clúster (CLAG) se utiliza para distribuir el tráfico entre los nodos del clúster. Un único CLAG gestiona el tráfico del cliente y del servidor. La redundancia de enlaces está habilitada en el CLAG, por lo que solo se selecciona un “subcanal” en un momento dado y gestiona el tráfico. Si algún enlace falla o el rendimiento cae por debajo del umbral especificado, se selecciona el otro subcanal.

- El conmutador ascendente realiza un equilibrio de carga simétrico entre puertos y canales (por ejemplo, el algoritmo source-dest-ip only de Cisco IOS 7.0 (8) N1 (1)) de modo que los flujos de tráfico directo e inverso los gestione el mismo nodo del clúster. Esta propiedad es deseable porque elimina el reordenamiento de paquetes, lo que degradaría el rendimiento del TCP.

- Se espera que el cincuenta por ciento del tráfico de datos se dirija a la placa base, lo que significa que cada nodo dirigirá hasta 34 Gbps a otros nodos del clúster (25 Gbps en condiciones de funcionamiento normales y 34 Gbps en caso de fallo en un solo nodo del clúster). Por lo tanto, cada nodo necesita al menos conexiones de 4x10G al conmutador de plano posterior. Para proporcionar redundancia en caso de fallo del conmutador, implementamos un par de conmutadores de plano posterior y duplicamos el número de conexiones. Actualmente, la redundancia de enlaces no es compatible con la placa base, por lo que se recomienda Cisco VPC o una tecnología equivalente para lograr la redundancia a nivel de conmutador.

- El tamaño de la MTU de los paquetes dirigidos es de 1578 bytes, por lo que los conmutadores de plano posterior deben admitir una MTU de más de 1500 bytes.

Nota: El diseño representado en la ilustración 1 también es aplicable a los dispositivos T1120 y T1310. Para el T1310 utilizaríamos interfaces de 40 GbE para las conexiones de la placa base, ya que carece de puertos de 10 GbE.

Nota: Si bien este documento utiliza Cisco VPC como ejemplo, si se trabaja con switches que no sean de Cisco, se podrían utilizar soluciones equivalentes alternativas, como el MLAG de Juniper.

Nota: Si bien son posibles otras topologías, como ECMP en lugar de CLAG, actualmente no se admiten para este caso de uso en particular.

Configuración de la optimización de TCP en un clúster NetScaler T1000

Una vez finalizadas la instalación física, la conectividad física, la instalación del software y las licencias, puede continuar con la configuración real del clúster. Las configuraciones descritas a continuación se aplican al clúster representado en la Imagen 1.

Nota: Para obtener más información sobre la configuración del clúster, consulte Configurar un clúster de NetScaler.

Suponga que los cuatro nodos T1300 de la Imagen 1 tienen las siguientes direcciones NSIP:

Cuatro nodos T1300 con dirección NSIP:

T1300-40-1: 10.102.29.60

T1300-40-2: 10.102.29.70

T1300-40-3: 10.102.29.80

T1300-40-4: 10.102.29.90

El clúster se administrará a través de la dirección IP del clúster (CLIP), que se supone que es 10.78.16.61.

Configuración del clúster

Para empezar a configurar el clúster que se muestra en la figura 1, inicie sesión en el primer dispositivo que desee agregar al clúster (por ejemplo, T1300-40-1) y haga lo siguiente.

-

En el símbolo del sistema, introduzca los siguientes comandos:

Comando:

> add cluster instance 1 > add cluster node 0 10.102.29.60 -state ACTIVE > add ns ip 10.102.29.61 255.255.255.255 -type clip > enable cluster instance 1 > save ns config > reboot –warm -

Después de reiniciar el dispositivo, conéctese a la dirección IP del clúster (CLIP) y agregue el resto de los nodos al clúster:

Comando:

> add cluster node 1 10.102.29.70 -state ACTIVE > add cluster node 2 10.102.29.80 -state ACTIVE > add cluster node 3 10.102.29.90 –state ACTIVE > save ns config -

Conéctese a la dirección NSIP de cada uno de los nodos recién agregados y únase al clúster:

Comando:

> join cluster -clip 10.102.29.61 -password nsroot > save ns config > reboot –warm -

Después de reiniciar los nodos, continúe con la configuración del plano posterior. En la dirección IP del clúster, introduzca los siguientes comandos para crear un canal LACP para el enlace de la placa base de cada nodo del clúster:

Comando:

> set interface 0/10/[1-8] –lacpkey 1 –lacpmode ACTIVE > set interface 1/10/[1-8] –lacpkey 2 –lacpmode ACTIVE > set interface 2/10/[1-8] –lacpkey 3 –lacpmode ACTIVE > set interface 3/10/[1-8] –lacpkey 4 –lacpmode ACTIVE -

Del mismo modo, configure LA dinámica y VPC en los conmutadores del plano posterior. Asegúrese de que la MTU de las interfaces del conmutador de plano posterior sea de al menos 1578 bytes.

-

Verifique que los canales estén operativos:

Comando:

> show channel 0/LA/1 > show channel 1/LA/2 > show channel 2/LA/3 > show channel 3/LA/4 -

Configure las interfaces del plano posterior del nodo del clúster.

Comando:

> set cluster node 0 -backplane 0/LA/1 > set cluster node 1 -backplane 1/LA/2 > set cluster node 2 -backplane 2/LA/3 > set cluster node 3 –backplane 3/LA/4 -

Compruebe el estado del clúster y compruebe que el clúster está operativo:

> show cluster instance > show cluster node

Para obtener más información sobre la configuración de clústeres, consulte Configuración de un clúster de NetScaler

Distribuir tráfico entre nodos de clúster

Después de crear el clúster de NetScaler, implemente la agregación de enlaces de clústeres (CLAG) para distribuir el tráfico entre los nodos del clúster. Un único enlace CLAG gestionará el tráfico del cliente y del servidor.

En la dirección IP del clúster, ejecute los siguientes comandos para crear el grupo de agregación de enlaces de clúster (CLAG) que se muestra en la figura 1:

Comando:

> set interface 0/40/[1-4] -lacpMode active -lacpKey 5 -lagType Cluster

> set interface 1/40/[1-4] -lacpMode active -lacpKey 5 -lagType Cluster

> set interface 2/40/[1-4] -lacpMode active -lacpKey 5 -lagType Cluster

> set interface 3/40/[1-4] -lacpMode active -lacpKey 5 -lagType Cluster

Configure la agregación de vínculos dinámicos en los conmutadores externos.

A continuación, habilite la redundancia de enlaces de la siguiente manera:

Código:

> set channel CLA/1 -linkRedundancy ON -lrMinThroughput 240000

Por último, compruebe el estado del canal introduciendo:

Comando:

> show channel CLA/1

El canal debe estar UP y el rendimiento real debe ser 320000.

Para obtener más información sobre la agregación de enlaces de clústeres, consulte los siguientes temas:

Debido a que vamos a utilizar el reenvío basado en MAC (MBF), configurar un conjunto de vínculos y vincularlo al grupo CLAG de la siguiente manera:

Comando:

> add linkset LS/1

> bind linkset LS/1 -ifnum CLA/1

Para obtener más información acerca de los conjuntos de vínculos, consulte los siguientes temas:

Configuración de direcciones IP y VLAN

Utilizaremos la configuración IP de rayas, lo que significa que las direcciones IP están activas en todos los nodos (configuración predeterminada). Consulte Configuraciones rayadas, parcialmente rayadas y manchadas para obtener más información sobre este tema.

-

Agregue los SNIP de entrada y salida:

Comando:

> add ns ip 172.16.30.254 255.255.255.0 –type SNIP > add ns ip 172.16.31.254 255.255.255.0 –type SNIP > add ns ip6 fd00:172:16:30::254/112 –type SNIP > add ns ip6 fd00:172:16:31::254/112 –type SNIP -

Agregue las VLAN de entrada y salida correspondientes:

Comando:

> add vlan 30 -aliasName wireless > add vlan 31 -aliasName internet -

Vincular VLAN con IPs y conjunto de vínculos:

Comando:

> bind vlan 31 -ifnum LS/1 -tagged > bind vlan 30 -ifnum LS/1 -tagged > bind vlan 30 -IPAddress 172.16.30.254 255.255.255.0 > bind vlan 31 -IPAddress 172.16.31.254 255.255.255.0 > bind vlan 30 -IPAddress fd00:172:16:30::254/112 > bind vlan 31 -IPAddress fd00:172:16:31::254/112

Se pueden agregar más VLAN de entrada y salida si es necesario.

Configuración de la optimización de TCP

En este punto, hemos aplicado todos los comandos específicos del clúster. Para completar la configuración, siga los pasos descritos en Configuración de optimización TCP.

Configuración de redirección dinámica

Se puede integrar un clúster de NetScaler en el entorno de enrutamiento dinámico de la red del cliente. A continuación se muestra un ejemplo de configuración de redirección dinámica mediante el protocolo de redirección BGP (también se admite OSPF).

-

Desde la dirección CLIP, habilite BGP y el redirección dinámica en las direcciones IP de entrada y salida:

Comando:

> enable ns feature bgp > set ns ip 172.16.30.254 –dynamicRouting ENABLED > set ns ip 172.16.31.254 –dynamicRouting ENABLED -

Abra vtysh y configure BGP para el lado de salida:

Código:

> shell root@ns# vtysh ns# configure terminal ns(config)# router bgp 65531 ns(config-router)# network 10.0.0.0/24 ns(config-router)# neighbor 172.16.31.100 remote-as 65530 ns(config-router)# neighbor 172.16.31.100 update-source 172.16.31.254 ns(config-router)# exit ns(config)# ns route-install propagate ns(config)# ns route-install default ns(config)# ns route-install bgp ns(config)# exit -

Configure el par BGP del lado de salida para anunciar la ruta predeterminada al clúster de NetScaler. Por ejemplo:

Comando:

router bgp 65530 bgp router-id 172.16.31.100 network 0.0.0.0/0 neighbor 172.16.31.254 remote-as 65531 -

Siga pasos similares para configurar el lado de entrada.

-

Desde vtysh, compruebe que la configuración se propaga a todos los nodos del clúster introduciendo:

Comando:

ns# show running-config -

Finalmente, inicie sesión en la dirección NSIP de cada nodo del clúster y verifique las rutas anunciadas desde el peer BGP:

Comando:

> show route | grep BGP