-

-

Implementar una instancia de NetScaler VPX

-

Optimice el rendimiento de NetScaler VPX en VMware ESX, Linux KVM y Citrix Hypervisors

-

Mejore el rendimiento de SSL-TPS en plataformas de nube pública

-

Configurar subprocesos múltiples simultáneos para NetScaler VPX en nubes públicas

-

Instalar una instancia de NetScaler VPX en un servidor desnudo

-

Instalar una instancia de NetScaler VPX en Citrix Hypervisor

-

Instalación de una instancia de NetScaler VPX en VMware ESX

-

Configurar NetScaler VPX para usar la interfaz de red VMXNET3

-

Configurar NetScaler VPX para usar la interfaz de red SR-IOV

-

Configurar NetScaler VPX para usar Intel QAT para la aceleración de SSL en modo SR-IOV

-

Migración de NetScaler VPX de E1000 a interfaces de red SR-IOV o VMXNET3

-

Configurar NetScaler VPX para usar la interfaz de red de acceso directo PCI

-

-

Instalación de una instancia NetScaler VPX en la nube de VMware en AWS

-

Instalación de una instancia NetScaler VPX en servidores Microsoft Hyper-V

-

Instalar una instancia de NetScaler VPX en la plataforma Linux-KVM

-

Requisitos previos para instalar dispositivos virtuales NetScaler VPX en la plataforma Linux-KVM

-

Aprovisionamiento del dispositivo virtual NetScaler mediante OpenStack

-

Aprovisionamiento del dispositivo virtual NetScaler mediante Virtual Machine Manager

-

Configuración de dispositivos virtuales NetScaler para que usen la interfaz de red SR-IOV

-

Configuración de dispositivos virtuales NetScaler para que usen la interfaz de red PCI Passthrough

-

Aprovisionamiento del dispositivo virtual NetScaler mediante el programa virsh

-

Administración de las máquinas virtuales invitadas de NetScaler

-

Aprovisionamiento del dispositivo virtual NetScaler con SR-IOV en OpenStack

-

-

Implementar una instancia de NetScaler VPX en AWS

-

Configurar las funciones de IAM de AWS en la instancia de NetScaler VPX

-

Implementación de una instancia independiente NetScaler VPX en AWS

-

Servidores de equilibrio de carga en diferentes zonas de disponibilidad

-

Implementar un par de alta disponibilidad de VPX en la misma zona de disponibilidad de AWS

-

Alta disponibilidad en diferentes zonas de disponibilidad de AWS

-

Implementar un par de alta disponibilidad VPX con direcciones IP privadas en distintas zonas de AWS

-

Implementación de una instancia NetScaler VPX en AWS Outposts

-

Proteja AWS API Gateway mediante el firewall de aplicaciones web de Citrix

-

Configurar una instancia de NetScaler VPX para utilizar la interfaz de red SR-IOV

-

Configurar una instancia de NetScaler VPX para utilizar redes mejoradas con AWS ENA

-

Implementar una instancia de NetScaler VPX en Microsoft Azure

-

Arquitectura de red para instancias NetScaler VPX en Microsoft Azure

-

Configuración de varias direcciones IP para una instancia independiente NetScaler VPX

-

Configurar una configuración de alta disponibilidad con varias direcciones IP y NIC

-

Configurar una instancia de NetScaler VPX para usar redes aceleradas de Azure

-

Configure los nodos HA-INC mediante la plantilla de alta disponibilidad de NetScaler con Azure ILB

-

Instalación de una instancia NetScaler VPX en la solución Azure VMware

-

Configurar una instancia independiente de NetScaler VPX en la solución Azure VMware

-

Configurar una instalación de alta disponibilidad de NetScaler VPX en la solución Azure VMware

-

Configurar el servidor de rutas de Azure con un par de alta disponibilidad de NetScaler VPX

-

Configurar GSLB en una configuración de alta disponibilidad activa en espera

-

Configuración de grupos de direcciones (IIP) para un dispositivo NetScaler Gateway

-

Scripts de PowerShell adicionales para la implementación de Azure

-

Implementación de una instancia NetScaler VPX en Google Cloud Platform

-

Implementar un par de VPX de alta disponibilidad en Google Cloud Platform

-

Implementar un par de alta disponibilidad VPX con direcciones IP privadas en Google Cloud Platform

-

Instalar una instancia de NetScaler VPX en VMware Engine de Google Cloud

-

Compatibilidad con escalado VIP para la instancia NetScaler VPX en GCP

-

-

Automatizar la implementación y las configuraciones de NetScaler

-

Actualización y degradación de un dispositivo NetScaler

-

Consideraciones de actualización para configuraciones con directivas clásicas

-

Consideraciones sobre la actualización de archivos de configuración personalizados

-

Consideraciones sobre la actualización: Configuración de SNMP

-

Compatibilidad con actualización de software en servicio para alta disponibilidad

-

Soluciones para proveedores de servicios de telecomunicaciones

-

Equilibrio de carga del tráfico de plano de control basado en protocolos de diámetro, SIP y SMPP

-

Utilización del ancho de banda mediante la funcionalidad de redirección de caché

-

-

Autenticación, autorización y auditoría del tráfico de aplicaciones

-

Cómo funciona la autenticación, la autorización y la auditoría

-

Componentes básicos de la configuración de autenticación, autorización y auditoría

-

Autorización del acceso de los usuarios a los recursos de aplicaciones

-

NetScaler como proxy del servicio de federación de Active Directory

-

NetScaler Gateway local como proveedor de identidad de Citrix Cloud

-

Compatibilidad de configuración para el atributo de cookie SameSite

-

Configuración de autenticación, autorización y auditoría para protocolos de uso común

-

Solución de problemas relacionados con la autenticación y la autorización

-

-

-

-

Configurar una expresión de directiva avanzada: Cómo empezar

-

Expresiones de directiva avanzadas: trabajar con fechas, horas y números

-

Expresiones de directiva avanzadas: Análisis de datos HTTP, TCP y UDP

-

Expresiones de directiva avanzadas: análisis de certificados SSL

-

Expresiones de directivas avanzadas: direcciones IP y MAC, rendimiento, ID de VLAN

-

Expresiones de directivas avanzadas: funciones de análisis de transmisiones

-

Expresiones de directiva avanzadas que utilizan la especificación de API

-

Ejemplos de tutoriales de directivas avanzadas para la reescritura

-

-

-

Protecciones de nivel superior

-

Protección basada en gramática SQL para cargas útiles HTML y JSON

-

Protección basada en gramática por inyección de comandos para carga útil HTML

-

Reglas de relajación y denegación para gestionar ataques de inyección HTML SQL

-

Compatibilidad con palabras clave personalizadas para la carga útil HTML

-

Compatibilidad con firewall de aplicaciones para Google Web Toolkit

-

Comprobaciones de protección XML

-

Caso de uso: Vincular la directiva de Web App Firewall a un servidor virtual VPN

-

-

-

Administrar un servidor virtual de redirección de caché

-

Ver estadísticas del servidor virtual de redirección de caché

-

Habilitar o inhabilitar un servidor virtual de redirección de caché

-

Resultados directos de directivas a la caché en lugar del origen

-

Realizar una copia de seguridad de un servidor virtual de redirección de caché

-

Habilitar la comprobación de estado TCP externa para servidores virtuales UDP

-

-

Traducir la dirección IP de destino de una solicitud a la dirección IP de origen

-

-

Descripción general del cluster

-

Administración del clúster de NetScaler

-

Grupos de nodos para configuraciones detectadas y parcialmente rayadas

-

Desactivación de la dirección en el plano posterior del clúster

-

Eliminar un nodo de un clúster implementado mediante la agregación de vínculos de clúster

-

Supervisión de la configuración del clúster mediante SNMP MIB con enlace SNMP

-

Supervisión de los errores de propagación de comandos en una implementación de clúster

-

Compatibilidad con logotipos preparados para IPv6 para clústeres

-

Enlace de interfaz VRRP en un clúster activo de un solo nodo

-

Casos de configuración y uso de clústeres

-

Migración de una configuración de HA a una configuración de clúster

-

Interfaces comunes para cliente y servidor e interfaces dedicadas para backplane

-

Conmutador común para cliente y servidor y conmutador dedicado para placa posterior

-

Supervisar servicios en un clúster mediante la supervisión de rutas

-

-

Configurar NetScaler como un solucionador de stubs con reconocimiento de seguridad no validante

-

Compatibilidad con tramas gigantes para DNS para gestionar respuestas de grandes tamaños

-

Configurar el almacenamiento en caché negativo de los registros DNS

-

Caso de uso: Configurar la función de administración automática de claves de DNSSEC

-

Caso de uso: Configurar la administración automática de claves DNSSEC en la implementación de GSLB

-

-

Estado de servicio y servidor virtual de equilibrio de carga

-

Insertar atributos de cookie a las cookies generadas por ADC

-

Proteja una configuración de equilibrio de carga contra fallos

-

Administrar el tráfico de clientes

-

Configurar servidores virtuales de equilibrio de carga sin sesión

-

Reescritura de puertos y protocolos para la redirección HTTP

-

Insertar la dirección IP y el puerto de un servidor virtual en el encabezado de solicitud

-

Utilizar una IP de origen especificada para la comunicación de back-end

-

Establecer un valor de tiempo de espera para las conexiones de cliente inactivas

-

Gestionar el tráfico de clientes en función de la velocidad de tráfico

-

Utilizar un puerto de origen de un rango de puertos especificado para la comunicación de back-end

-

Configurar la persistencia IP de origen para la comunicación back-end

-

-

Configuración avanzada de equilibrio de carga

-

Aumenta gradualmente la carga en un nuevo servicio con un inicio lento a nivel de servidor virtual

-

Proteger aplicaciones en servidores protegidos contra los picos de tráfico

-

Habilitar la limpieza de las conexiones de servicios y servidores virtuales

-

Habilitar o inhabilitar la sesión de persistencia en los servicios TROFS

-

Habilitar la comprobación de estado TCP externa para servidores virtuales UDP

-

Mantener la conexión de cliente para varias solicitudes de cliente

-

Insertar la dirección IP del cliente en el encabezado de solicitud

-

Utilizar la dirección IP de origen del cliente al conectarse al servidor

-

Configurar el puerto de origen para las conexiones del lado del servidor

-

Establecer un límite en el número de solicitudes por conexión al servidor

-

Establecer un valor de umbral para los monitores enlazados a un servicio

-

Establecer un valor de tiempo de espera para las conexiones de clientes inactivas

-

Establecer un valor de tiempo de espera para las conexiones de servidor inactivas

-

Establecer un límite en el uso del ancho de banda por parte de los clientes

-

Conservar el identificador de VLAN para la transparencia de VLAN

-

-

Configurar monitores en una configuración de equilibrio de carga

-

Configurar el equilibrio de carga para los protocolos de uso común

-

Caso de uso 3: Configurar el equilibrio de carga en modo de Direct Server Return

-

Caso de uso 6: Configurar el equilibrio de carga en modo DSR para redes IPv6 mediante el campo TOS

-

Caso de uso 7: Configurar el equilibrio de carga en modo DSR mediante IP sobre IP

-

Caso de uso 8: Configurar el equilibrio de carga en modo de un brazo

-

Caso de uso 9: Configurar el equilibrio de carga en modo en línea

-

Caso de uso 10: Equilibrio de carga de los servidores del sistema de detección de intrusiones

-

Caso de uso 11: Aislamiento del tráfico de red mediante directivas de escucha

-

Caso de uso 12: Configurar Citrix Virtual Desktops para el equilibrio de carga

-

Caso de uso 13: Configurar Citrix Virtual Apps and Desktops para equilibrar la carga

-

Caso de uso 14: Asistente de ShareFile para equilibrar la carga Citrix ShareFile

-

Caso práctico 15: Configurar el equilibrio de carga de capa 4 en el dispositivo NetScaler

-

-

Configurar para obtener el tráfico de datos NetScaler FreeBSD desde una dirección SNIP

-

-

-

Matriz de compatibilidad de certificados de servidor en el dispositivo ADC

-

Compatibilidad con plataformas basadas en chip SSL Intel Coleto

-

Compatibilidad con el módulo de seguridad de hardware Thales Luna Network

-

-

-

-

Configuración de un túnel de CloudBridge Connector entre dos centros de datos

-

Configuración de CloudBridge Connector entre el centro de datos y la nube de AWS

-

Configuración de un túnel de CloudBridge Connector entre un centro de datos y Azure Cloud

-

Configuración del túnel CloudBridge Connector entre Datacenter y SoftLayer Enterprise Cloud

-

Diagnóstico y solución de problemas de túnel CloudBridge Connector

-

-

Puntos a tener en cuenta para una configuración de alta disponibilidad

-

Sincronizar archivos de configuración en una configuración de alta disponibilidad

-

Restricción del tráfico de sincronización de alta disponibilidad a una VLAN

-

Configuración de nodos de alta disponibilidad en distintas subredes

-

Limitación de las conmutaciones por error causadas por monitores de ruta en modo no INC

-

Configuración del conjunto de interfaces de conmutación por error

-

Administración de mensajes de latido de alta disponibilidad en un dispositivo NetScaler

-

Quitar y reemplazar un NetScaler en una configuración de alta disponibilidad

-

This content has been machine translated dynamically.

Dieser Inhalt ist eine maschinelle Übersetzung, die dynamisch erstellt wurde. (Haftungsausschluss)

Cet article a été traduit automatiquement de manière dynamique. (Clause de non responsabilité)

Este artículo lo ha traducido una máquina de forma dinámica. (Aviso legal)

此内容已经过机器动态翻译。 放弃

このコンテンツは動的に機械翻訳されています。免責事項

이 콘텐츠는 동적으로 기계 번역되었습니다. 책임 부인

Este texto foi traduzido automaticamente. (Aviso legal)

Questo contenuto è stato tradotto dinamicamente con traduzione automatica.(Esclusione di responsabilità))

This article has been machine translated.

Dieser Artikel wurde maschinell übersetzt. (Haftungsausschluss)

Ce article a été traduit automatiquement. (Clause de non responsabilité)

Este artículo ha sido traducido automáticamente. (Aviso legal)

この記事は機械翻訳されています.免責事項

이 기사는 기계 번역되었습니다.책임 부인

Este artigo foi traduzido automaticamente.(Aviso legal)

这篇文章已经过机器翻译.放弃

Questo articolo è stato tradotto automaticamente.(Esclusione di responsabilità))

Translation failed!

Optimice el rendimiento de NetScaler VPX en VMware ESX, Linux KVM y Citrix Hypervisors

El rendimiento de NetScaler VPX varía considerablemente según el hipervisor, los recursos del sistema asignados y las configuraciones del host. Para lograr el rendimiento deseado, primero siga las recomendaciones de la hoja de datos de VPX y, a continuación, optimice aún más mediante las prácticas recomendadas que se proporcionan en este documento.

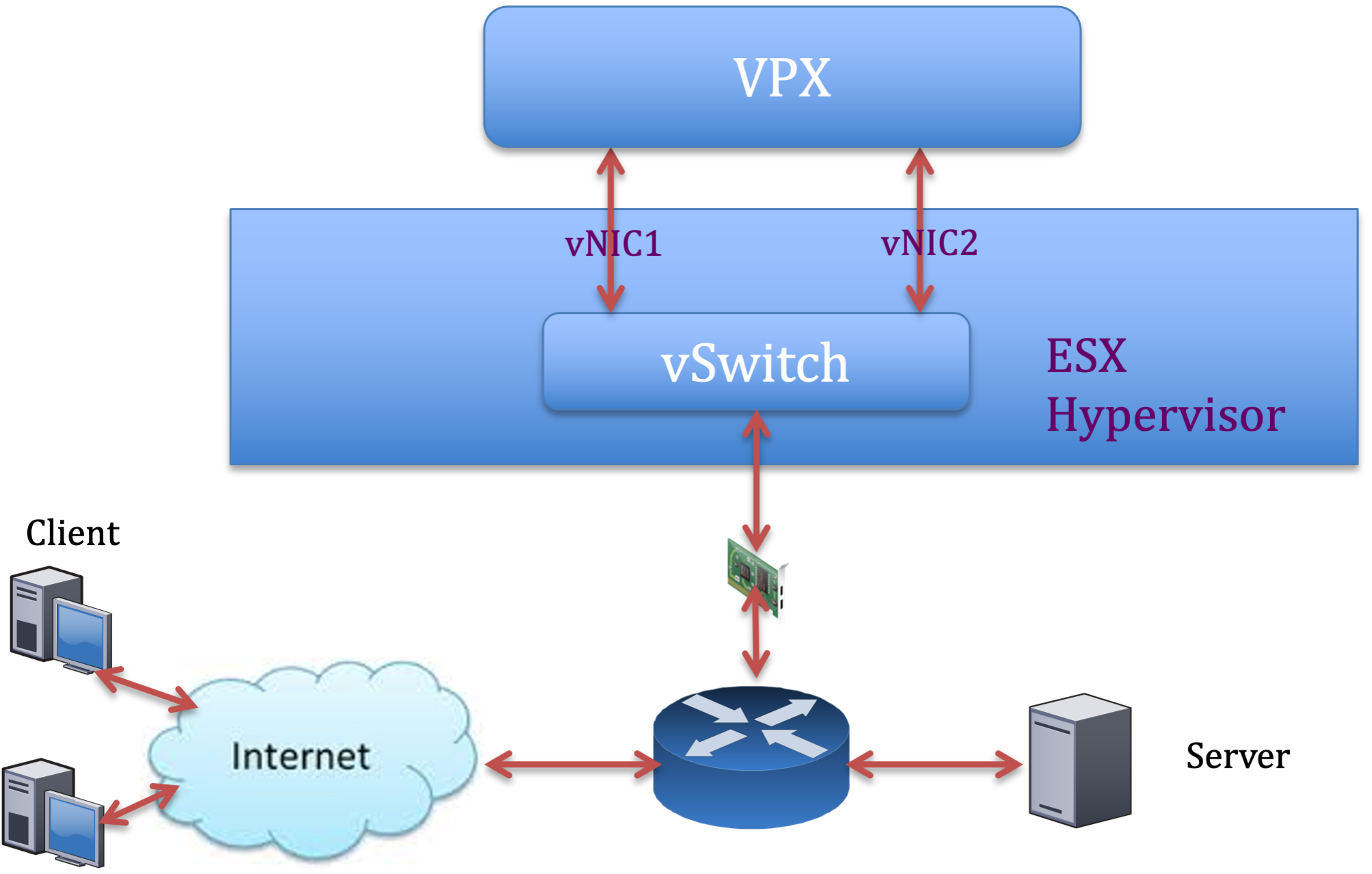

Instancia de NetScaler VPX en hipervisores VMware ESX

Esta sección contiene detalles sobre las opciones y ajustes configurables y otras sugerencias que le ayudarán a lograr un rendimiento óptimo de la instancia de NetScaler VPX en los hipervisores VMware ESX.

- Configuración recomendada en hosts ESX

- NetScaler VPX con interfaces de red E1000

- NetScaler VPX con interfaces de red VMXNET3

- NetScaler VPX con interfaces de red de transferencia SR-IOV y PCI

Configuración recomendada en hosts ESX

Para lograr un alto rendimiento para VPX con interfaces de red de paso E1000, VMXNET3, SR-IOV y PCI, siga estas recomendaciones:

- El número total de CPU virtuales (vCPU) aprovisionadas en el host ESX debe ser inferior o igual al número total de CPU físicas (PCPU) del host ESX.

-

La afinidad de acceso a memoria no uniforme (NUMA) y la afinidad de CPU deben configurarse para que el host ESX obtenga buenos resultados.

— Para encontrar la afinidad NUMA de un Vmnic, inicie sesión en el host de forma local o remota y escriba:

#vsish -e get /net/pNics/vmnic7/properties | grep NUMA Device NUMA Node: 0 <!--NeedCopy-->- Para establecer la afinidad de NUMA y vCPU para una VM, consulte la documentación de VMware.

NetScaler VPX con interfaces de red E1000

Realice la siguiente configuración en el host de VMware ESX:

- En el host VMware ESX, cree dos vNIC a partir de un conmutador vNIC. Varias vNIC crean varios subprocesos de recepción (Rx) en el host ESX. Esto aumenta el rendimiento de Rx de la interfaz pNIC.

- Habilite las VLAN en el nivel de grupo de puertos de vSwitch para cada vNIC que haya creado.

- Para aumentar el rendimiento de transmisión de vNIC (Tx), utilice un subproceso Tx independiente en el host ESX por vNIC. Utilice el siguiente comando de ESX:

-

Para la versión 5.5 de ESX:

esxcli system settings advanced set –o /Net/NetTxWorldlet –i <!--NeedCopy--> -

Para la versión 6.0 de ESX en adelante:

esxcli system settings advanced set -o /Net/NetVMTxType –i 1 <!--NeedCopy-->

-

-

Para aumentar aún más el rendimiento de vNIC Tx, utilice un subproceso de finalización Tx y una cola de subprocesos Rx por dispositivo (NIC) independientes. Utilice el siguiente comando de ESX:

esxcli system settings advanced set -o /Net/NetNetqRxQueueFeatPairEnable -i 0 <!--NeedCopy-->

Nota:

Asegúrese de reiniciar el host de VMware ESX para aplicar la configuración actualizada.

Dos vNIC por implementación de pNIC

A continuación se muestra un ejemplo de comandos de topología y configuración para el modelo de implementación Dos vNIC por pNIC que ofrece un mejor rendimiento de la red.

Ejemplo de configuración de NetScaler VPX:

Para lograr la implementación que se muestra en la topología de ejemplo anterior, realice la siguiente configuración en la instancia de NetScaler VPX:

-

En el lado del cliente, vincule el SNIP (1.1.1.2) a la interfaz de red 1/1 y habilite el modo de etiqueta VLAN.

bind vlan 2 -ifnum 1/1 –tagged bind vlan 2 -IPAddress 1.1.1.2 255.255.255.0 <!--NeedCopy--> -

En el lado del servidor, vincule el SNIP (2.2.2.2) a la interfaz de red 1/1 y habilite el modo de etiqueta VLAN.

bind vlan 3 -ifnum 1/2 –tagged bind vlan 3 -IPAddress 2.2.2.2 255.255.255.0 <!--NeedCopy--> -

Agregar un servidor virtual HTTP (1.1.1.100) y vincularlo a un servicio (2.2.2.100).

add lb vserver v1 HTTP 1.1.1.100 80 -persistenceType NONE -Listenpolicy None -cltTimeout 180 add service s1 2.2.2.100 HTTP 80 -gslb NONE -maxClient 0 -maxReq 0 -cip DISABLED -usip NO -useproxyport YES -sp ON -cltTimeout 180 -svrTimeout 360 -CKA NO -TCPB NO -CMP NO bind lb vserver v1 s1 <!--NeedCopy-->

Nota:

Asegúrese de incluir las dos entradas siguientes en la tabla de rutas:

- subred 1.1.1.0/24 con puerta de enlace apuntando a SNIP 1.1.1.2

- Subred 2.2.2.0/24 con puerta de enlace que apunta a SNIP 2.2.2.2

NetScaler VPX con interfaces de red VMXNET3

Para lograr un alto rendimiento para VPX con interfaces de red VMXNET3, realice la siguiente configuración en el host VMware ESX:

- Cree dos vNIC a partir de un vSwitch pNIC. Varias vNIC crean varios subprocesos Rx en el host ESX. Esto aumenta el rendimiento de Rx de la interfaz pNIC.

- Habilite las VLAN en el nivel de grupo de puertos de vSwitch para cada vNIC que haya creado.

- Para aumentar el rendimiento de transmisión de vNIC (Tx), utilice un subproceso Tx independiente en el host ESX por vNIC. Utilice los siguientes comandos de ESX:

- Para la versión 5.5 de ESX:

esxcli system settings advanced set –o /Net/NetTxWorldlet –i <!--NeedCopy-->- Para la versión 6.0 de ESX en adelante:

esxcli system settings advanced set -o /Net/NetVMTxType –i 1 <!--NeedCopy-->

En el host de VMware ESX, realice la siguiente configuración:

- En el host VMware ESX, cree dos vNIC a partir de 1 vSwitch pNIC. Varias vNIC crean varios subprocesos Tx y Rx en el host ESX. Esto aumenta el rendimiento Tx y Rx de la interfaz pNIC.

- Habilite las VLAN en el nivel de grupo de puertos de vSwitch para cada vNIC que haya creado.

-

Para aumentar el rendimiento de Tx de una vNIC, utilice un subproceso de finalización Tx y una cola de subprocesos Rx por dispositivo (NIC) independientes. Utilice el siguiente comando:

esxcli system settings advanced set -o /Net/NetNetqRxQueueFeatPairEnable -i 0 <!--NeedCopy--> -

Configure una máquina virtual para que use un subproceso de transmisión por vNIC, agregando la siguiente configuración a la configuración de la máquina virtual:

ethernetX.ctxPerDev = "1" <!--NeedCopy--> -

Para configurar una máquina virtual para que utilice hasta 8 subprocesos de transmisión por vNIC, agregue la siguiente configuración a la configuración de la máquina virtual:

ethernetX.ctxPerDev = "3" <!--NeedCopy-->Nota:

El aumento de los subprocesos de transmisión por vNIC requiere más recursos de CPU (hasta 8) en el host ESX. Asegúrese de que haya suficientes recursos de CPU disponibles antes de realizar la configuración anterior.

Para obtener más información, consulte Prácticas recomendadas para el ajuste del rendimiento de las cargas de trabajo de telecomunicaciones y NFV en vSphere

Nota:

Asegúrese de reiniciar el host de VMware ESX para aplicar la configuración actualizada.

Puede configurar VMXNET3 como dos vNIC por implementación de PNIC . Para obtener más información, consulte Dos vNIC por implementación de PNIC.

Configure la compatibilidad con múltiples colas y RSS en VMware ESX para dispositivos VMXNET3

De forma predeterminada, el dispositivo VMXNET3 solo admite 8 colas Rx y Tx. Cuando el número de vCPU en el VPX supera los 8, el número de colas Rx y Tx configuradas para una interfaz VMXNET3 cambia a 1 de forma predeterminada. Puede configurar hasta 19 colas Rx y Tx para dispositivos VMXNET3 cambiando determinadas configuraciones en ESX. Esta opción aumenta el rendimiento y la distribución uniforme de los paquetes entre las CPU virtuales de la instancia VPX.

Nota:

A partir de la versión 13.1, compilación 48.x de NetScaler, NetScaler VPX admite hasta 19 colas Rx y Tx en dispositivos ESX para VMXNET3.

Requisitos previos:

Para configurar hasta 19 colas Rx y Tx en ESX para dispositivos VMXNET3, asegúrese de que se cumplen los siguientes requisitos previos:

- La versión de NetScaler VPX es 13.1, compilación 48.X y posterior.

- NetScaler VPX se configura con una máquina virtual de hardware de versión 17 o posterior, que es compatible con VMware ESX 7.0 y versiones posteriores.

Configure las interfaces VMXNET3 para que admitan más de 8 colas Rx y Tx:

- Abra el archivo de configuración de la máquina virtual (.vmx).

-

Especifique el número de colas Rx y TX configurando

ethernetX.maxRxQueueslos valoresethernetX.maxTxQueuesy (donde X es el número de NIC virtuales que se van a configurar). La cantidad máxima de colas configuradas no debe ser superior a la cantidad de CPU virtuales de la máquina virtual.Nota:

El aumento del número de colas también aumenta la sobrecarga del procesador en el host ESX. Por lo tanto, asegúrese de que haya suficientes recursos de CPU disponibles en el host ESX antes de aumentar las colas. Puede aumentar el número máximo de colas admitidas en situaciones en las que el número de colas se identifique como un obstáculo para el rendimiento. En estas situaciones, recomendamos aumentar el número de colas de forma gradual. Por ejemplo, de 8 a 12, luego a 16, luego a 20, y así sucesivamente. Evalúe el rendimiento en cada configuración, en lugar de aumentarlo directamente hasta el límite máximo.

NetScaler VPX con interfaces de red de transferencia SR-IOV y PCI

Para lograr un alto rendimiento para VPX con interfaces de red de paso SR-IOV y PCI, consulte Configuración recomendada en hosts ESX.

Instancia NetScaler VPX en la plataforma Linux-KVM

Esta sección contiene detalles sobre las opciones y los ajustes configurables, así como otras sugerencias que le ayudarán a lograr un rendimiento óptimo de la instancia NetScaler VPX en la plataforma Linux-KVM.

- Configuración de rendimiento para KVM

- NetScaler VPX con interfaces de red fotovoltaica

- NetScaler VPX con interfaces de red de transferencia SR-IOV y Fortville PCIe

Configuración de rendimiento para KVM

Realice los siguientes ajustes en el host KVM:

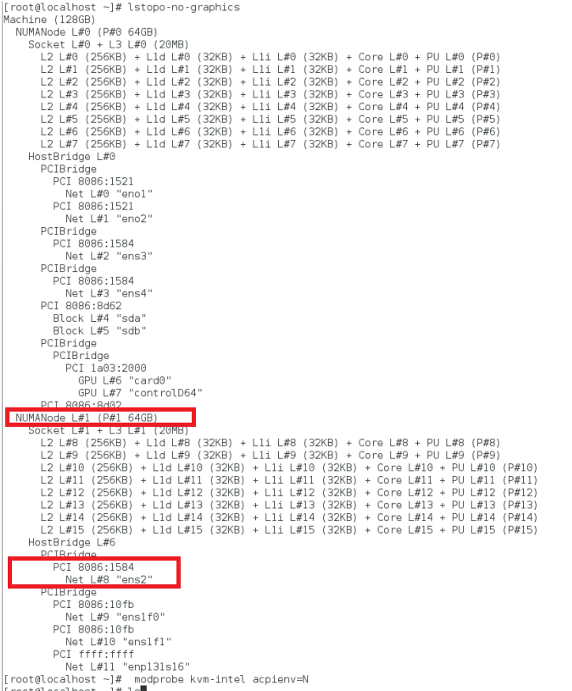

Busque el dominio NUMA de la NIC mediante el comando lstopo:

Asegúrese de que la memoria del VPX y de la CPU esté fijada en la misma ubicación. En el siguiente resultado, la NIC 10G “ens2” está vinculada al dominio NUMA #1.

Asigne la memoria VPX del dominio NUMA.

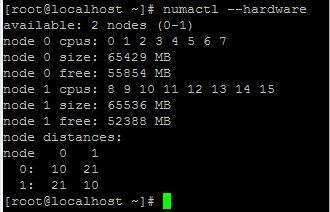

El comando numactl indica el dominio NUMA desde el que se asigna la memoria. En el siguiente resultado, se asignan unos 10 GB de RAM desde el nodo NUMA #0.

Para cambiar la asignación de nodos NUMA, sigue estos pasos.

-

Modifique el archivo.xml del VPX en el host.

/etc/libvirt/qemu/<VPX_name>.xml <!--NeedCopy--> -

Agrega la siguiente etiqueta:

<numatune> <memory mode="strict" nodeset="1"/> This is the NUMA domain name </numatune> <!--NeedCopy--> -

Apaga el VPX.

-

Ejecute este comando:

virsh define /etc/libvirt/qemu/<VPX_name>.xml <!--NeedCopy-->Este comando actualiza la información de configuración de la máquina virtual con las asignaciones de nodos NUMA.

-

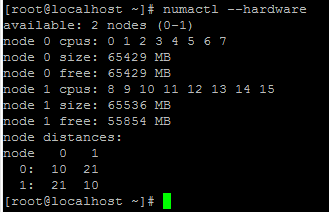

Enciende el VPX. A continuación, compruebe el resultado del comando

numactl –hardwareen el host para ver las asignaciones de memoria actualizadas para el VPX.

Anclar vCPU de VPX a núcleos físicos.

-

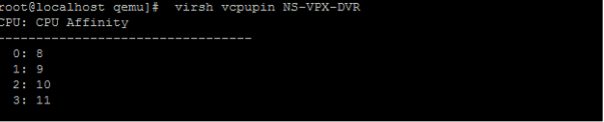

Para ver las asignaciones de vCPU a PCPU de un VPX, escriba el siguiente comando

virsh vcpupin <VPX name> <!--NeedCopy-->

Las vCPU 0—4 se asignan a los núcleos físicos 8—11.

-

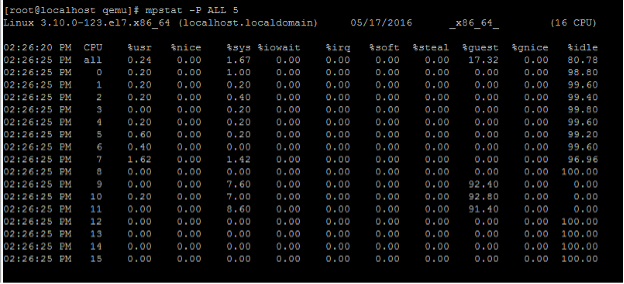

Para ver el uso actual de la PCPU, escriba el siguiente comando:

mpstat -P ALL 5 <!--NeedCopy-->

En este resultado, 8 es CPU de administración y 9-11 son motores de paquetes.

-

Para cambiar la fijación de vCPU a PCPU, hay dos opciones.

-

Cámbielo en tiempo de ejecución después de que se inicie el VPX con el siguiente comando:

virsh vcpupin <VPX name> <vCPU id> <pCPU number> virsh vcpupin NetScaler-VPX-XML 0 8 virsh vcpupin NetScaler-VPX-XML 1 9 virsh vcpupin NetScaler-VPX-XML 2 10 virsh vcpupin NetScaler-VPX-XML 3 11 <!--NeedCopy--> -

Para realizar cambios estáticos en el VPX, modifique el archivo

.xmlcomo antes con las siguientes etiquetas:-

Modificar el archivo.xml del VPX en el host

/etc/libvirt/qemu/<VPX_name>.xml <!--NeedCopy--> -

Agrega la siguiente etiqueta:

<vcpu placement='static' cpuset='8-11'>4</vcpu> <cputune> <vcpupin vcpu='0' cpuset='8'/> <vcpupin vcpu='1' cpuset='9'/> <vcpupin vcpu='2' cpuset='10'/> <vcpupin vcpu='3' cpuset='11'/> </cputune> <!--NeedCopy--> -

Apaga el VPX.

-

Actualice la información de configuración de la máquina virtual con las asignaciones de nodos NUMA mediante el siguiente comando:

virsh define /etc/libvirt/qemu/ <VPX_name>.xml <!--NeedCopy--> -

Enciende el VPX. A continuación, compruebe el resultado del comando

virsh vcpupin <VPX name>en el host para ver la fijación actualizada de la CPU.

-

-

Elimine la sobrecarga de interrupción del host.

-

Detecte VM_EXITS mediante el comando

kvm_stat.En el nivel del hipervisor, las interrupciones del host se asignan a las mismas PCPU en las que están fijadas las vCPU de la VPX. Esto podría provocar que las vCPU de la VPX se expulsaran periódicamente.

Para encontrar las salidas de VM realizadas por las máquinas virtuales que ejecutan el host, use el comando

kvm_stat.[root@localhost ~]# kvm_stat -1 | grep EXTERNAL kvm_exit(EXTERNAL_INTERRUPT) 1728349 27738 [root@localhost ~]# <!--NeedCopy-->Un valor más alto del orden 1+M indica un problema.

Si hay una sola máquina virtual, el valor esperado es de 30 a 100 K. Si hay más de eso, puede indicar que hay uno o más vectores de interrupción del host asignados a la misma PCPU.

-

Detecte las interrupciones del host y migre las interrupciones del host.

Al ejecutar el comando

concatenatedel archivo “/proc/interrupts”, muestra todas las asignaciones de interrupción del host. Si una o más IRQ activas se asignan a la misma PCPU, su contador correspondiente aumenta.Transfiera cualquier interrupción que se superponga con las PCPUs de NetScaler VPX a las PCPUs no utilizadas:

echo 0000000f > /proc/irq/55/smp_affinity 0000000f - - > it is a bitmap, LSBs indicates that IRQ 55 can only be scheduled on pCPUs 0 – 3 <!--NeedCopy--> -

Desactiva el saldo de IRQ.

Inhabilite el demonio de equilibrio de IRQ para que no se produzca ninguna reprogramación sobre la marcha.

service irqbalance stop service irqbalance show - To check the status service irqbalance start - Enable if needed <!--NeedCopy-->Asegúrese de ejecutar el comando

kvm_statpara asegurarse de que no haya muchos contadores.

NetScaler VPX con interfaces de red fotovoltaica

Puede configurar las interfaces de red de paso de para-virtualización (PV), SR-IOV y PCIe como dos vNIC por implementación de PNIC . Para obtener más información, consulte Dos vNIC por implementación de PNIC.

Para obtener un rendimiento óptimo de las interfaces fotovoltaicas (virtio), siga estos pasos:

- Identifique el dominio NUMA al que pertenece la ranura PCIe/NIC.

- La memoria y la vCPU del VPX deben estar ancladas en el mismo dominio NUMA.

- El subproceso vhost debe estar enlazado a las CPU del mismo dominio NUMA.

Enlazar los subprocesos del host virtual a las CPU correspondientes:

-

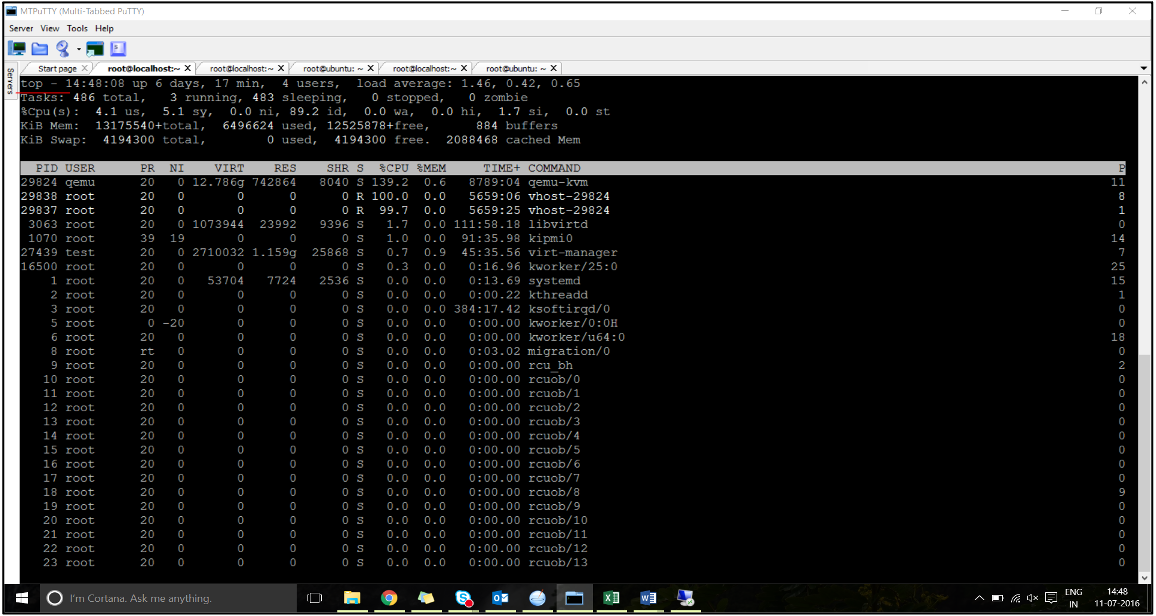

Una vez iniciado el tráfico, ejecute el comando

topen el host.

- Identificar el proceso de host virtual (denominado como

vhost-<pid-of-qemu>) afinidad. -

Enlace los procesos vHost a los núcleos físicos del dominio NUMA identificado anteriormente mediante el siguiente comando:

taskset –pc <core-id> <process-id> <!--NeedCopy-->Ejemplo:

taskset –pc 12 29838 <!--NeedCopy--> -

Los núcleos del procesador correspondientes al dominio NUMA se pueden identificar con el siguiente comando:

[root@localhost ~]# virsh capabilities | grep cpu <cpu> </cpu> <cpus num='8'> <cpu id='0' socket_id='0' core_id='0' siblings='0'/> <cpu id='1' socket_id='0' core_id='1' siblings='1'/> <cpu id='2' socket_id='0' core_id='2' siblings='2'/> <cpu id='3' socket_id='0' core_id='3' siblings='3'/> <cpu id='4' socket_id='0' core_id='4' siblings='4'/> <cpu id='5' socket_id='0' core_id='5' siblings='5'/> <cpu id='6' socket_id='0' core_id='6' siblings='6'/> <cpu id='7' socket_id='0' core_id='7' siblings='7'/> </cpus> <cpus num='8'> <cpu id='8' socket_id='1' core_id='0' siblings='8'/> <cpu id='9' socket_id='1' core_id='1' siblings='9'/> <cpu id='10' socket_id='1' core_id='2' siblings='10'/> <cpu id='11' socket_id='1' core_id='3' siblings='11'/> <cpu id='12' socket_id='1' core_id='4' siblings='12'/> <cpu id='13' socket_id='1' core_id='5' siblings='13'/> <cpu id='14' socket_id='1' core_id='6' siblings='14'/> <cpu id='15' socket_id='1' core_id='7' siblings='15'/> </cpus> <cpuselection/> <cpuselection/> <!--NeedCopy-->

Enlazar el proceso QEMU al núcleo físico correspondiente:

- Identificar los núcleos físicos en los que se ejecuta el proceso QEMU. Para obtener más información, consulte el resultado anterior.

-

Enlace el proceso QEMU a los mismos núcleos físicos a los que vincula las vCPU mediante el siguiente comando:

taskset –pc 8-11 29824 <!--NeedCopy-->

NetScaler VPX con interfaces de red de transferencia SR-IOV y Fortville PCIe

Para obtener un rendimiento óptimo de las interfaces de red de paso SR-IOV y Fortville PCIe, siga estos pasos:

- Identifique el dominio NUMA al que pertenece la ranura PCIe/NIC.

- La memoria y la vCPU del VPX deben estar ancladas al mismo dominio NUMA.

Archivo XML VPX de ejemplo para vCPU y fijación de memoria para Linux KVM:

<domain type='kvm'>

<name>NetScaler-VPX</name>

<uuid>138f7782-1cd3-484b-8b6d-7604f35b14f4</uuid>

<memory unit='KiB'>8097152</memory>

<currentMemory unit='KiB'>8097152</currentMemory>

<vcpu placement='static'>4</vcpu>

<cputune>

<vcpupin vcpu='0' cpuset='8'/>

<vcpupin vcpu='1' cpuset='9'/>

<vcpupin vcpu='2' cpuset='10'/>

<vcpupin vcpu='3' cpuset='11'/>

</cputune>

<numatune>

<memory mode='strict' nodeset='1'/>

</numatune>

</domain>

<!--NeedCopy-->

Instancia de NetScaler VPX en Citrix Hypervisors

Esta sección contiene detalles de las opciones y ajustes configurables y otras sugerencias que le ayudarán a lograr un rendimiento óptimo de la instancia de NetScaler VPX en Citrix Hypervisors.

- Configuración de rendimiento de Citrix Hypervisors

- NetScaler VPX con interfaces de red SR-IOV

- NetScaler VPX con interfaces paravirtualizadas

Configuración de rendimiento de Citrix Hypervisors

Busque el dominio NUMA de la NIC mediante el comando “xl”:

xl info -n

<!--NeedCopy-->

Anclar vCPU de VPX a núcleos físicos.

xl vcpu-pin <Netsclaer VM Name> <vCPU id> <physical CPU id>

<!--NeedCopy-->

Compruebe la vinculación de las vCPU.

xl vcpu-list

<!--NeedCopy-->

Asigne más de 8 vCPU a las máquinas virtuales NetScaler.

Para configurar más de 8 vCPU, ejecute los siguientes comandos desde la consola de Citrix Hypervisor:

xe vm-param-set uuid=your_vms_uuid VCPUs-max=16

xe vm-param-set uuid=your_vms_uuid VCPUs-at-startup=16

<!--NeedCopy-->

NetScaler VPX con interfaces de red SR-IOV

Para obtener un rendimiento óptimo de las interfaces de red SR-IOV, siga estos pasos:

- Identifique el dominio NUMA al que está vinculada la ranura PCIe o la NIC.

- Anclar la memoria y la vCPU del VPX al mismo dominio NUMA.

- Enlaza la vCPU Domain-0 a la CPU restante.

NetScaler VPX con interfaces paravirtualizadas

Para obtener un rendimiento óptimo, se recomiendan dos vNIC por cada pNIC y una vNIC por cada pNIC, como en otros entornos fotovoltaicos.

Para lograr un rendimiento óptimo de las interfaces para-virtualizadas (netfront), siga estos pasos:

- Identifique el dominio NUMA al que pertenece la ranura PCIe o la NIC.

- Anclar la memoria y la vCPU del VPX al mismo dominio NUMA.

- Enlazar la vCPU Domain-0 a la CPU restante del mismo dominio NUMA.

- Anclar subprocesos Rx/Tx del host de vNIC a vCPU de dominio 0.

Anclar subprocesos de host a vCPU Domain-0:

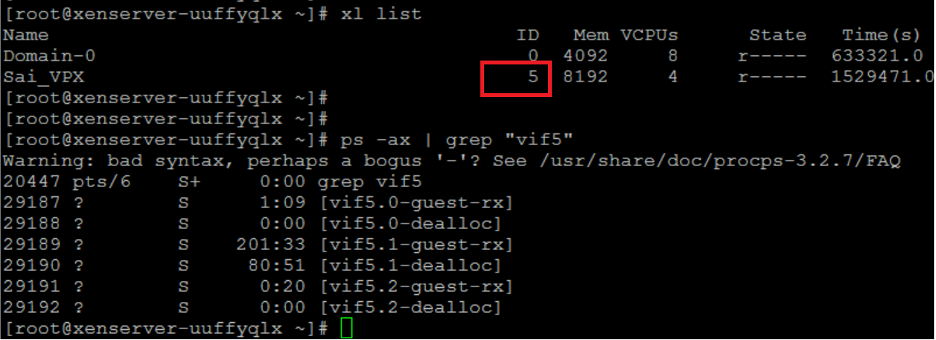

- Busque Xen-ID del VPX mediante el comando

xl listdel shell de host de Citrix Hypervisor. -

Identifique los subprocesos de host mediante el siguiente comando:

ps -ax | grep vif <Xen-ID> <!--NeedCopy-->En el siguiente ejemplo, estos valores indican:

- vif5.0 : los subprocesos de la primera interfaz asignada a VPX en XenCenter (interfaz de administración).

- vif5.1 : los hilos de la segunda interfaz asignada a VPX, etc.

-

Anclar los subprocesos a las vCPU Domain-0 mediante el siguiente comando:

taskset –pc <core-id> <process-id> <!--NeedCopy-->Ejemplo:

taskset -pc 1 29189 <!--NeedCopy-->

Compartir

Compartir

This Preview product documentation is Cloud Software Group Confidential.

You agree to hold this documentation confidential pursuant to the terms of your Cloud Software Group Beta/Tech Preview Agreement.

The development, release and timing of any features or functionality described in the Preview documentation remains at our sole discretion and are subject to change without notice or consultation.

The documentation is for informational purposes only and is not a commitment, promise or legal obligation to deliver any material, code or functionality and should not be relied upon in making Cloud Software Group product purchase decisions.

If you do not agree, select I DO NOT AGREE to exit.