-

-

Configuration de Citrix ADC pour Citrix Virtual Apps and Desktops

-

Préférence de zone optimisée Global Server Load Balancing (GSLB)

-

Déployez une plateforme publicitaire numérique sur AWS avec Citrix ADC

-

Amélioration de l'analyse du flux de clics dans AWS à l'aide de Citrix ADC

-

Citrix ADC dans un cloud privé géré par Microsoft Windows Azure Pack et Cisco ACI

-

-

Déployer une instance de Citrix ADC VPX sur AWS

-

Matrice de prise en charge et directives d'utilisation

-

Optimisation des performances Citrix ADC VPX sur VMware ESX, Linux KVM et Citrix Hypervisors

-

Installer une instance Citrix ADC VPX sur le cloud VMware sur AWS

-

Installer une instance Citrix ADC VPX sur les serveurs Microsoft Hyper-V

-

Installer une instance Citrix ADC VPX sur la plate-forme Linux-KVM

-

Provisionnement de l'appliance virtuelle Citrix ADC à l'aide d'OpenStack

-

Provisionnement de l'appliance virtuelle Citrix ADC à l'aide du gestionnaire de machines virtuelles

-

Configuration des appliances virtuelles Citrix ADC pour utiliser l'interface réseau SR-IOV

-

Configuration des appliances virtuelles Citrix ADC pour utiliser l'interface réseau PCI Passthrough

-

Provisionnement de l'appliance virtuelle Citrix ADC à l'aide du programme virsh

-

Provisionnement de l'appliance virtuelle Citrix ADC avec SR-IOV, sur OpenStack

-

Configuration d'une instance Citrix ADC VPX sur KVM pour utiliser les interfaces hôtes OVS DPDK

-

Deploy a Citrix ADC VPX instance on AWS

-

Serveurs d'équilibrage de charge dans différentes zones de disponibilité

-

Déployer une paire HA VPX dans la même zone de disponibilité AWS

-

Haute disponibilité dans différentes zones de disponibilité AWS

-

Déployez une paire VPX haute disponibilité avec des adresses IP privées dans différentes zones AWS

-

Configurer une instance Citrix ADC VPX pour utiliser l'interface réseau SR-IOV

-

Configurer une instance Citrix ADC VPX pour utiliser la mise en réseau améliorée avec AWS ENA

-

Déployer une instance de Citrix ADC VPX sur Microsoft Azure

-

Architecture réseau pour les instances Citrix ADC VPX sur Microsoft Azure

-

Configurer plusieurs adresses IP pour une instance autonome Citrix ADC VPX

-

Configurer une configuration haute disponibilité avec plusieurs adresses IP et cartes réseau

-

Configurer une instance Citrix ADC VPX pour utiliser la mise en réseau accélérée Azure

-

Configurer les nœuds HA-INC à l'aide du modèle Citrix haute disponibilité avec Azure ILB

-

Installer une instance Citrix ADC VPX sur la solution Azure VMware

-

Ajouter des paramètres de mise à l'échelle automatique Azure

-

Configurer GSLB sur une configuration haute disponibilité active en veille

-

Configurer les pools d'adresses (IIP) pour un dispositif NetScaler Gateway

-

Scripts PowerShell supplémentaires pour le déploiement Azure

-

Déployer une instance Citrix ADC VPX sur Google Cloud Platform

-

Automatiser le déploiement et les configurations de Citrix ADC

-

-

Solutions pour les fournisseurs de services de télécommunication

-

Trafic du plan de contrôle de l'équilibrage de charge basé sur les protocoles Diameter, SIP et SMPP

-

Utilisation de la bande passante avec la fonctionnalité de redirection du cache

-

-

Authentification, autorisation et audit du trafic des applications

-

Fonctionnement de l'authentification, de l'autorisation et de l'audit

-

Composants de base de la configuration de l'authentification, de l'autorisation et de l'audit

-

-

Autorisation de l'accès des utilisateurs aux ressources de l'application

-

Citrix ADC en tant que proxy Active Directory Federation Service

-

NetScaler Gateway sur site en tant que fournisseur d'identité vers Citrix Cloud

-

Prise en charge de la configuration de l'attribut de cookie SameSite

-

Résoudre les problèmes liés à l'authentification et à l'autorisation

-

-

-

-

Configuration de l'expression de stratégie avancée : mise en route

-

Expressions de stratégie avancées : utilisation des dates, des heures et des nombres

-

Expressions de stratégie avancées : analyse des données HTTP, TCP et UDP

-

Expressions de stratégie avancées : analyse des certificats SSL

-

Expressions de stratégie avancées : adresses IP et MAC, débit, ID VLAN

-

Expressions de stratégie avancées : fonctions d'analyse de flux

-

Référence des expressions - Expressions de stratégie avancées

-

Exemples récapitulatifs d'expressions et de stratégies de syntaxe par défaut

-

Tutoriel sur les exemples de stratégies syntaxiques par défaut pour la réécriture

-

Migration des règles Apache mod_rewrite vers la syntaxe par défaut

-

-

-

-

Vérifications de protection XML

-

Articles sur les alertes de signatures

-

-

Traduire l'adresse IP de destination d'une requête vers l'adresse IP d'origine

-

-

Prise en charge de la configuration Citrix ADC dans un cluster

-

-

-

Groupes de nœuds pour les configurations repérées et partiellement entrelacées

-

Désactivation de la direction sur le fond de panier du cluster

-

Suppression d'un nœud d'un cluster déployé à l'aide de l'agrégation de liens de cluster

-

Surveillance de la configuration du cluster à l'aide de la MIB SNMP avec lien SNMP

-

Surveillance des échecs de propagation des commandes dans un déploiement de cluster

-

Liaison d'interface VRRP dans un cluster actif à nœud unique

-

Scénarios de configuration et d'utilisation du cluster

-

Migration d'une configuration HA vers une configuration de cluster

-

Interfaces communes pour le client et le serveur et interfaces dédiées pour le fond de panier

-

Commutateur commun pour le client, le serveur et le fond de panier

-

Commutateur commun pour client et serveur et commutateur dédié pour fond de panier

-

Services de surveillance dans un cluster à l'aide de la surveillance des chemins

-

Opérations prises en charge sur des nœuds de cluster individuels

-

-

-

Configurer les enregistrements de ressources DNS

-

Créer des enregistrements MX pour un serveur d'échange de messagerie

-

Créer des enregistrements NS pour un serveur faisant autorité

-

Créer des enregistrements NAPTR pour le domaine des télécommunications

-

Créer des enregistrements PTR pour les adresses IPv4 et IPv6

-

Créer des enregistrements SOA pour les informations faisant autorité

-

Créer des enregistrements TXT pour contenir du texte descriptif

-

Configurer Citrix ADC en tant que résolveur de stub non validant sensible à la sécurité

-

Prise en charge des trames Jumbo pour le DNS pour gérer les réponses de grande taille

-

Configurer la mise en cache négative des enregistrements DNS

-

-

Équilibrage de charge de serveur global

-

Configurez les entités GSLB individuellement

-

Synchronisation de la configuration dans une configuration GSLB

-

Cas d'utilisation : déploiement d'un groupe de services Autoscale basé sur l'adresse IP

-

-

Remplacer le comportement de proximité statique en configurant les emplacements préférés

-

Configuration de la sélection des services GSLB à l'aide du changement de contenu

-

Configurer GSLB pour les requêtes DNS avec des enregistrements NAPTR

-

Exemple de configuration parent-enfant complète à l'aide du protocole d'échange de métriques

-

-

Équilibrer la charge du serveur virtuel et des états de service

-

Protection d'une configuration d'équilibrage de charge contre les défaillances

-

-

Configuration des serveurs virtuels d'équilibrage de charge sans session

-

Réécriture des ports et des protocoles pour la redirection HTTP

-

Insérer l'adresse IP et le port d'un serveur virtuel dans l'en-tête de requête

-

Utiliser une adresse IP source spécifiée pour la communication principale

-

Définir une valeur de délai d'expiration pour les connexions client inactives

-

Utiliser un port source d'une plage de ports spécifiée pour les communications en arrière-plan

-

Configurer la persistance de l'adresse IP source pour la communication principale

-

-

Paramètres d'équilibrage de charge avancés

-

Protégez les applications sur les serveurs protégés contre les pics de trafic

-

Activer le nettoyage des connexions de serveur virtuel et de service

-

Activer ou désactiver la session de persistance sur les services TROFS

-

Activer la vérification de l'état TCP externe pour les serveurs virtuels UDP

-

Maintenir la connexion client pour plusieurs demandes client

-

Utiliser l'adresse IP source du client lors de la connexion au serveur

-

Définissez une limite sur le nombre de demandes par connexion au serveur

-

Définir une valeur de seuil pour les moniteurs liés à un service

-

Définir une valeur de délai d'attente pour les connexions client inactives

-

Définir une valeur de délai d'attente pour les connexions de serveur inactives

-

Définir une limite sur l'utilisation de la bande passante par les clients

-

Conserver l'identificateur VLAN pour la transparence du VLAN

-

Configurer les moniteurs dans une configuration d'équilibrage de charge

-

Configurer l'équilibrage de charge pour les protocoles couramment utilisés

-

Cas d'utilisation 3 : configurer l'équilibrage de charge en mode de retour direct du serveur

-

Cas d'utilisation 4 : Configuration des serveurs LINUX en mode DSR

-

Cas d'utilisation 5 : configurer le mode DSR lors de l'utilisation de TOS

-

Cas d'utilisation 7 : Configurer l'équilibrage de charge en mode DSR à l'aide d'IP sur IP

-

Cas d'utilisation 8 : Configurer l'équilibrage de charge en mode à un bras

-

Cas d'utilisation 9 : Configurer l'équilibrage de charge en mode en ligne

-

Cas d'utilisation 10 : Équilibrage de charge des serveurs de systèmes de détection d'intrusion

-

Cas d'utilisation 11 : Isolation du trafic réseau à l'aide de stratégies d'écoute

-

Cas d'utilisation 12 : configurer Citrix Virtual Desktops pour l'équilibrage de charge

-

Cas d'utilisation 13 : Configuration de Citrix Virtual Apps pour l'équilibrage de charge

-

Cas d'utilisation 14 : Assistant ShareFile pour l'équilibrage de charge Citrix ShareFile

-

Cas d'utilisation 15 : configurer l'équilibrage de charge de couche 4 sur l'appliance Citrix ADC

-

-

-

Configuration pour générer le trafic de données Citrix ADC FreeBSD à partir d'une adresse SNIP

-

-

Déchargement et accélération SSL

-

Prise en charge du protocole TLSv1.3 tel que défini dans la RFC 8446

-

Suites de chiffrement disponibles sur les appliances Citrix ADC

-

Matrice de prise en charge des certificats de serveur sur l'appliance ADC

-

Prise en charge du module de sécurité matérielle Thales Luna Network

-

-

-

-

Authentification et autorisation pour les utilisateurs système

-

Configuration des utilisateurs, des groupes d'utilisateurs et des stratégies de commande

-

Réinitialisation du mot de passe administrateur par défaut (nsroot)

-

Configuration de l'authentification des utilisateurs externes

-

Authentification par clé SSH pour les administrateurs Citrix ADC

-

Authentification à deux facteurs pour les utilisateurs système

-

-

-

Points à prendre en compte pour une configuration haute disponibilité

-

Synchronisation des fichiers de configuration dans une configuration haute disponibilité

-

Restriction du trafic de synchronisation haute disponibilité vers un VLAN

-

Configuration de nœuds haute disponibilité dans différents sous-réseaux

-

Limitation des basculements causés par les moniteurs de routage en mode non INC

-

Gestion des messages de pulsation haute disponibilité sur une appliance Citrix ADC

-

Supprimer et remplacer un Citrix ADC dans une configuration haute disponibilité

-

This content has been machine translated dynamically.

Dieser Inhalt ist eine maschinelle Übersetzung, die dynamisch erstellt wurde. (Haftungsausschluss)

Cet article a été traduit automatiquement de manière dynamique. (Clause de non responsabilité)

Este artículo lo ha traducido una máquina de forma dinámica. (Aviso legal)

此内容已经过机器动态翻译。 放弃

このコンテンツは動的に機械翻訳されています。免責事項

이 콘텐츠는 동적으로 기계 번역되었습니다. 책임 부인

Este texto foi traduzido automaticamente. (Aviso legal)

Questo contenuto è stato tradotto dinamicamente con traduzione automatica.(Esclusione di responsabilità))

This article has been machine translated.

Dieser Artikel wurde maschinell übersetzt. (Haftungsausschluss)

Ce article a été traduit automatiquement. (Clause de non responsabilité)

Este artículo ha sido traducido automáticamente. (Aviso legal)

この記事は機械翻訳されています.免責事項

이 기사는 기계 번역되었습니다.책임 부인

Este artigo foi traduzido automaticamente.(Aviso legal)

这篇文章已经过机器翻译.放弃

Questo articolo è stato tradotto automaticamente.(Esclusione di responsabilità))

Translation failed!

Matrice de prise en charge et directives d’utilisation

Ce document répertorie les différents hyperviseurs et les fonctionnalités prises en charge sur une instance Citrix ADC VPX. Le document décrit également leurs directives d’utilisation et leurs limitations connues.

Tableau 1 Instance VPX sur Citrix Hypervisor

| Version Citrix Hypervisor | SysID | Modèles VPX |

|---|---|---|

| 8.2 pris en charge à partir de 13.0, 64.x, 8.0, 7.6, 7.1 | 450000 | VPX 10, VPX 25, VPX 200, VPX 1000, VPX 3000, VPX 5000, VPX 8000, VPX 10 G, VPX 15 G, VPX 25 G, VPX 40 G |

Tableau 2. Instance VPX sur l’hyperviseur VMware ESXi

Les modèles VPX suivants avec 450010 (ID système) prennent en charge les versions de VMware ESX répertoriées dans le tableau.

Modèles VPX : VPX 10, VPX 25, VPX 200, VPX 1000, VPX 3000, VPX 5000, VPX 8000, VPX 10G, VPX 15G, VPX 25G, VPX 40G et VPX 100G.

| Version ESXi | Date de sortie d’ESXi au format MM/DD/YYYY

|

Numéro de build ESXi | Version Citrix ADC VPX |

|---|---|---|---|

| ESXi 8.0 mise à jour 2 | 09/21/2023 | 22380479 | versions 13.0-92.x et supérieures |

| ESXi 8.0 mise à jour 1 | 04/18/2023 | 21495797 | Versions 13.0-90.x et supérieures |

| ESXi 8.0 c | 03/30/2023 | 21493926 | Versions 13.0-90.x et supérieures |

| ESXi 8.0 | 10/11/2022 | 20513097 | Versions 13.0-90.x et supérieures |

| Mise à jour 3n d’ESXi 7.0 | 07/06/2023 | 21930508 | Versions 13.0-91.x et supérieures |

| Mise à jour ESXi 7.0 3m | 05/03/2023 | 21686933 | Versions 13.0-91.x et supérieures |

| Mise à jour 3i d’ESXi 7.0 | 12/08/2022 | 20842708 | Versions 13.0-90.x et supérieures |

| Mise à jour 3f d’ESXi 7.0 | 07/12/2022 | 20036589 | Versions 13.0-86.x et supérieures |

| Mise à jour d’ESXi 7.0 3d | 03/29/2022 | 19482537 | Versions 13.0-86.x et supérieures |

| ESXi 7.0 update 3c | 01/27/2022 | 19193900 | Versions 13.0-85.x et supérieures |

| ESXi 7.0 update 2d | 09/14/2021 | 18538813 | Versions 13.0-83.x et supérieures |

| ESXi 7.0 update 2a | 12/17/2020 | 17867351 | Versions 13.0-82.x et supérieures |

| ESXi 6.7 P04 | 11/19/2020 | 17167734 | Versions 13.0-67.x et supérieures |

| ESXi 6.7 P03 | 08/20/2020 | 16713306 | Versions 13.0-67.x et supérieures |

| ESXi 6.7 P02 | 04/28/2020 | 16075168 | Versions 13.0-67.x et supérieures |

| ESXi 6.7 mise à jour 3 | 08/20/2019 | 14320388 | Versions 13.0-58.x et supérieures |

| ESXi 6.5 U1g | 3/20/2018 | 7967591 | Versions 13.0 47.x et supérieures |

Remarque :

La prise en charge de chaque correctif ESXi est validée sur la version Citrix ADC VPX spécifiée dans le tableau précédent et s’applique à toutes les versions supérieures de la version Citrix ADC 13.0.

Tableau 3. VPX sur Microsoft Hyper-V

| Version Hyper-V | SysID | Modèles VPX |

|---|---|---|

| 2012, 2012R2, 2016, 2019 | 450020 | VPX 10, VPX 25, VPX 200, VPX 1000, VPX 3000 |

Instance VPX sur Nutanix AHV

NetScaler VPX est pris en charge sur Nutanix AHV dans le cadre du partenariat Citrix Ready. Citrix Ready est un programme de partenariat technologique qui aide les fournisseurs de logiciels et de matériel à développer et à intégrer leurs produits avec la technologie NetScaler pour les espaces de travail numériques, les réseaux et les analyses.

Assistance par des tiers :

Si vous rencontrez des problèmes lors de l’intégration d’un tiers en particulier (Nutanix AHV) dans un environnement NetScaler, signalez un incident de support directement auprès du partenaire tiers (Nutanix).

Si le partenaire détermine que le problème semble provenir de NetScaler, il peut contacter le support NetScaler pour obtenir une assistance supplémentaire. Une ressource technique dédiée issue de partenaires travaille avec le support NetScaler jusqu’à ce que le problème soit résolu.

Pour plus d’informations, consultez les FAQ du programme Citrix Ready Partner.

Tableau 4. Instance VPX sur KVM générique

| Version KVM générique | SysID | Modèles VPX |

|---|---|---|

| RHEL 7.4, RHEL 7.5 (à partir de Citrix ADC version 12.1 50.x et suivantes), RHEL 7.6, RHEL 8.2, Ubuntu 16.04, Ubuntu 18.04, RHV 4.2 | 450070 | VPX 10, VPX 25, VPX 200, VPX 1000, VPX 3000, VPX 5000, VPX 8000, VPX 10 G, VPX 15 G. VPX 25G, VPX 40G, VPX 100G |

Points à noter :

Lorsque vous utilisez les hyperviseurs KVM, tenez compte des points suivants.

-

L’instance VPX est qualifiée pour les versions de version de l’Hypervisor mentionnées dans le tableau 1—4, et non pour les versions de correctifs dans une version. Toutefois, l’instance VPX devrait fonctionner de manière transparente avec les versions de correctifs d’une version prise en charge. Si ce n’est pas le cas, consignez un dossier de support pour le dépannage et le débogage.

-

Utilisez les commandes

ip linkpour configurer les ponts réseau RHEL 8.2. - Avant d’utiliser RHEL 7.6, effectuez les étapes suivantes sur l’hôte KVM :

-

Modifiez /etc/default/grub et ajoutez

"kvm_intel.preemption_timer=0"à la variableGRUB_CMDLINE_LINUX. -

Régénérez le fichier grub.cfg à l’aide de la commande

"# grub2-mkconfig -o /boot/grub2/grub.cfg". -

Redémarrez la machine hôte.

-

-

Avant d’utiliser Ubuntu 18.04, effectuez les étapes suivantes sur l’hôte KVM :

- Modifiez /etc/default/grub et ajoutez

"kvm_intel.preemption_timer=0"à la variableGRUB_CMDLINE_LINUX. - Régénérez le fichier grub.cfg à l’aide de la commande

"# grub-mkconfig -o /boot/grub/grub.cfg “. - Redémarrez la machine hôte.

- Modifiez /etc/default/grub et ajoutez

Tableau 5. Instance VPX sur AWS

| Version AWS | SysID | Modèles VPX |

|---|---|---|

| S/O | 450040 | VPX 10, VPX 200, VPX 1000, VPX 3000, VPX 5000, VPX BYOL, VPX 8000, VPX 10G, VPX 15G et VPX 25G sont disponibles uniquement avec BYOL avec les types d’instances EC2 (C5, M5 et C5n) |

Remarque :

L’offre VPX 25G ne donne pas le débit 25G souhaité dans AWS mais peut donner un taux de transactions SSL plus élevé par rapport à l’offre VPX 15G.

Tableau 6. Instance VPX sur Azure

| Version Azure | SysID | Modèles VPX |

|---|---|---|

| S/O | 450020 | VPX 10, VPX 200, VPX 1000, VPX 3000, VPX 5000, VPX BYOL |

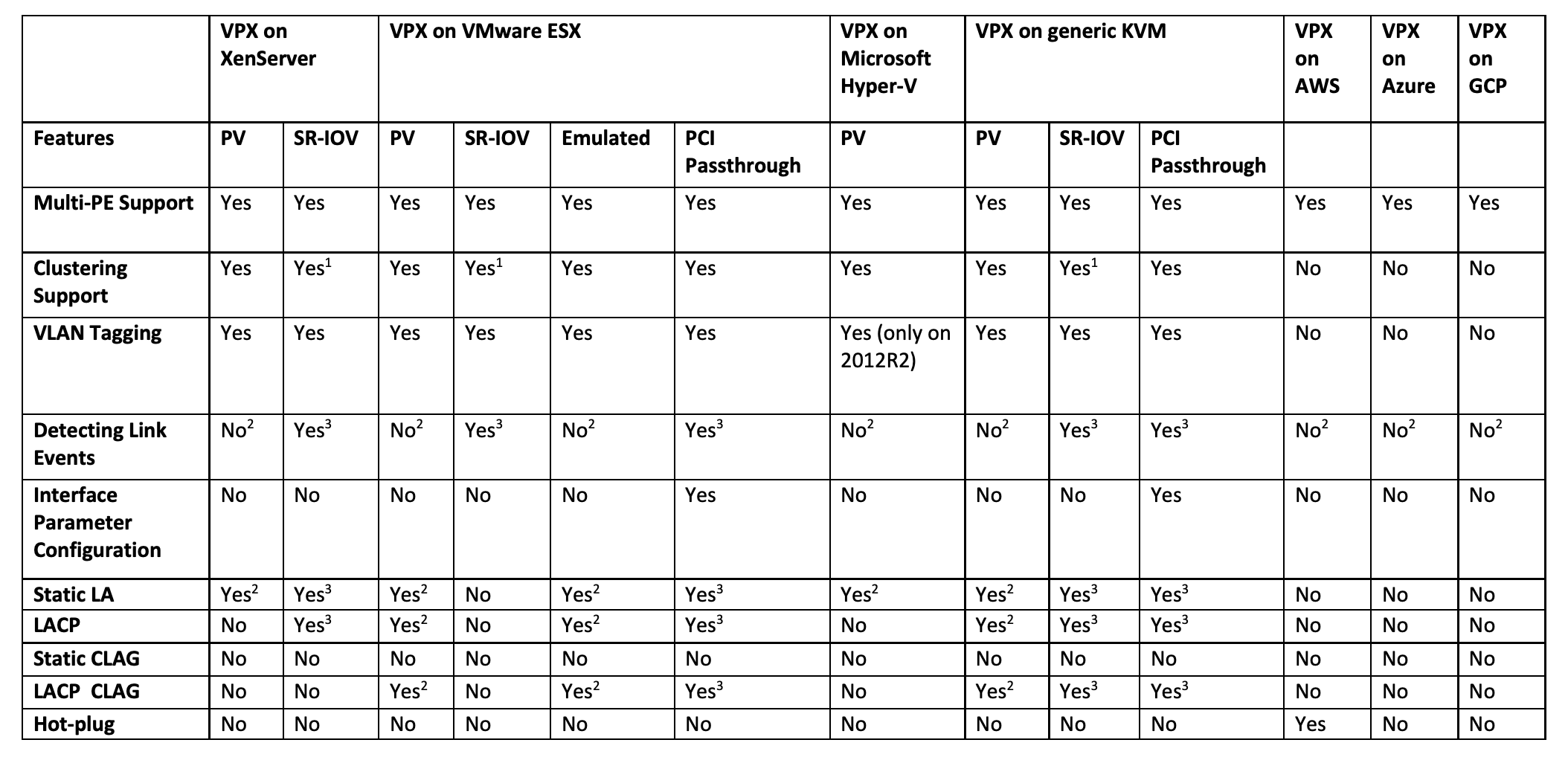

Tableau 7. Matrice de fonctionnalités VPX

Les nombres en exposant (1, 2, 3) utilisés dans le tableau précédent se réfèrent aux points suivants avec une numérotation respective :

-

La prise en charge du clustering est disponible sur SRIOV pour les interfaces côté client et côté serveur, et non pour le fond de panier.

-

Les événements DOWN de l’interface ne sont pas enregistrés dans les instances Citrix ADC VPX.

-

Pour LA statique, le trafic peut toujours être envoyé sur l’interface dont l’état physique est DOWN.

-

Pour LACP, le périphérique homologue connaît l’événement DOWN de l’interface basé sur le mécanisme de délai d’expiration LACP.

- Délai d’expiration court : 3 secondes

- Délai d’attente long : 90 secondes

-

Pour LACP, ne partagez pas les interfaces entre les machines virtuelles.

-

Pour le routage dynamique, le temps de convergence dépend du protocole de routage car les événements de liaison ne sont pas détectés.

-

La fonctionnalité Routage statique surveillé échoue si vous ne liez pas les moniteurs à des routes statiques, car l’état de l’itinéraire dépend de l’état du VLAN. L’état du VLAN dépend de l’état de la liaison.

-

La détection de défaillance partielle ne se produit pas en haute disponibilité en cas de défaillance de liaison. Une condition cérébrale divisée à haute disponibilité peut se produire en cas de défaillance de liaison.

-

Lorsqu’un événement de lien (désactiver/activer, réinitialiser) est généré à partir d’une instance VPX, l’état physique du lien ne change pas. Pour LA statique, tout trafic initié par le pair est supprimé sur l’instance.

-

Pour que la fonctionnalité de balisage VLAN fonctionne, procédez comme suit :

Sur VMware ESX, définissez l’ID VLAN du groupe de ports sur 1 à 4095 sur le vSwitch du serveur VMware ESX. Pour plus d’informations sur la définition d’un ID VLAN sur le vSwitch du serveur VMware ESX, consultez Solutions VLAN VMware ESX Server 3 802.1Q.

-

Tableau 8. Navigateurs pris en charge

| Système d’exploitation | Navigateur et versions |

|---|---|

| Windows 7 | Internet Explorer - 8, 9, 10 et 11 ; Mozilla Firefox 3.6.25 et versions ultérieures ; Google Chrome - 15 et versions ultérieures |

| Windows 64 bits | Internet Explorer - 8, 9 ; Google Chrome - 15 et versions ultérieures |

| MAC | Mozilla Firefox - 12 et versions ultérieures ; Safari - 5.1.3 ; Google Chrome - 15 et versions ultérieures |

Directives d’utilisation

Suivez ces instructions d’utilisation :

- Nous vous recommandons de déployer une instance VPX sur les disques locaux du serveur ou sur des volumes de stockage SAN.

Consultez la section Considérations relatives au processeur VMware ESXi dans le document Performance Best Practices for VMware vSphere 6.5. Voici un extrait :

-

Il n’est pas recommandé que les machines virtuelles dont la demande en CPU/mémoire est élevée se trouvent sur un hôte/un cluster surchargé.

-

Dans la plupart des environnements, ESXi permet des niveaux significatifs de surcharge du processeur sans affecter les performances des machines virtuelles. Sur un hôte, vous pouvez exécuter plus de processeurs virtuels que le nombre total de cœurs de processeur physiques de cet hôte.

-

Si un hôte ESXi devient saturé en processeur, c’est-à-dire que les machines virtuelles et les autres charges sur l’hôte exigent toutes les ressources CPU dont dispose l’hôte, les charges de travail sensibles à la latence risquent de ne pas fonctionner correctement. Dans ce cas, vous souhaiterez peut-être réduire la charge du processeur, par exemple en mettant hors tension certaines machines virtuelles ou en les migrant vers un autre hôte, ou en autorisant DRS à les migrer automatiquement.

-

Citrix recommande la dernière version de compatibilité matérielle pour bénéficier des derniers ensembles de fonctionnalités de l’hyperviseur ESXi pour la machine virtuelle. Pour plus d’informations sur la compatibilité matérielle et la version ESXi, consultez la documentation VMware.

-

Le Citrix ADC VPX est un dispositif virtuel hautes performances sensible à la latence. Pour fournir les performances attendues, le dispositif nécessite la réservation du processeur virtuel, la réservation de la mémoire et l’épinglage du processeur virtuel sur l’hôte. En outre, l’hyper thread doit être désactivé sur l’hôte. Si l’hôte ne répond pas à ces exigences, des problèmes tels que basculement haute disponibilité, pic de processeur dans l’instance VPX, lenteur dans l’accès à l’interface de ligne de commande VPX, plantage du démon pit boss, pertes de paquets et faible débit se produisent.

Un Hypervisor est considéré comme surapprovisionné si l’une des deux conditions suivantes est remplie :

-

Le nombre total de cœurs virtuels (vCPU) provisionnés sur l’hôte est supérieur au nombre total de cœurs physiques (PCPU).

-

Le nombre total de machines virtuelles provisionnées consomme plus de vCPU que le nombre total de processeurs physiques.

Si une instance est surapprovisionnée, il se peut que l’hyperviseur ne garantisse pas les ressources réservées (telles que le processeur, la mémoire et autres) pour l’instance en raison des surcharges de planification de l’hyperviseur, des bogues ou des limitations avec l’hyperviseur. Ce comportement peut entraîner un manque de ressources CPU pour Citrix ADC et peut entraîner les problèmes mentionnés au premier point sous Directives d’utilisation. En tant qu’administrateurs, il est recommandé de réduire la location de l’hôte afin que le nombre total de vCPU provisionnés sur l’hôte soit inférieur ou égal au nombre total de processeurs physiques.

Exemple

Pour l’hyperviseur ESX, si le paramètre

%RDY%d’un vCPU VPX est supérieur à 0 dans la sortie de la commandeesxtop, l’hôte ESX est dit avoir des surcharges de planification, ce qui peut entraîner des problèmes de latence pour l’instance VPX.Dans ce cas, réduisez la location sur l’hôte afin que

%RDY%revienne toujours à 0. Vous pouvez également contacter le fournisseur de l’hyperviseur pour trier la raison du non-respect de la réservation de ressources effectuée. - L’ajout à chaud n’est pris en charge que pour les interfaces PV et SRIOV avec Citrix ADC sur AWS. Les instances VPX avec interfaces ENA ne prennent pas en charge le branchement à chaud, et le comportement des instances peut être imprévisible en cas de tentative de connexion à chaud.

- La suppression à chaud via la console Web AWS ou l’interface de ligne de commande AWS n’est pas prise en charge avec les interfaces PV, SRIOV et ENA pour Citrix ADC. Le comportement des instances peut être imprévisible si la suppression à chaud est tentée.

Commandes pour contrôler l’utilisation du processeur du moteur de paquets

Vous pouvez utiliser deux commandes (set ns vpxparam et show ns vpxparam) pour contrôler le comportement d’utilisation du processeur du moteur de paquets (hors gestion) des instances VPX dans les environnements d’hyperviseur et de cloud :

-

set ns vpxparam [-cpuyield (YES | NO | DEFAULT)] [-masterclockcpu1 (YES | NO)]Autoriser chaque machine virtuelle à utiliser des ressources CPU qui ont été allouées à une autre machine virtuelle mais qui ne sont pas utilisées.

Paramètres

Set ns vpxparam:-cpuyield : libère ou ne libère pas des ressources CPU allouées mais inutilisées.

-

OUI : autorise l’utilisation des ressources CPU allouées mais inutilisées par une autre machine virtuelle.

-

NON : réservez toutes les ressources CPU pour la machine virtuelle à laquelle elles ont été allouées. Cette option affiche un pourcentage plus élevé dans les environnements d’hyperviseur et de cloud pour l’utilisation du processeur VPX.

-

DEFAULT : Non.

Remarque :

Sur toutes les plates-formes Citrix ADC VPX, l’utilisation du processeur virtuel sur le système hôte est de 100 %. Tapez la commande

set ns vpxparam –cpuyield YESpour remplacer cette utilisation.Si vous souhaitez définir les nœuds du cluster sur « rendement », vous devez effectuer les configurations supplémentaires suivantes sur CCO :

- Si un cluster est formé, tous les nœuds présentent « Yield=Default ».

- Si un cluster est formé à l’aide des nœuds déjà définis sur « Yield=YES », les nœuds sont ajoutés au cluster en utilisant le rendement « DEFAULT ».

Remarque :

Si vous souhaitez définir les nœuds du cluster sur « YIELD=YES », vous pouvez configurer uniquement après la formation du cluster, mais pas avant la formation du cluster.

-masterclockcpu1 : Vous pouvez déplacer la source d’horloge principale de CPU0 (CPU de gestion) vers CPU1. Ce paramètre a les options suivantes :

-

OUI : Autorisez la machine virtuelle à déplacer la source d’horloge principale de CPU0 vers CPU1.

-

NON : VM utilise CPU0 pour la source d’horloge principale. Par défaut, CPU0 est la principale source d’horloge.

-

-

show ns vpxparamAffichez les paramètres

vpxparamactuels.

Autres références

-

Pour les produits Citrix Ready, visitez Citrix Ready Marketplace.

-

Pour obtenir le support produit Citrix Ready, consultez la page FAQ.

-

Pour les versions matérielles VMware ESX, consultez Mise à niveau de VMware Tools.

Partager

Partager

This Preview product documentation is Cloud Software Group Confidential.

You agree to hold this documentation confidential pursuant to the terms of your Cloud Software Group Beta/Tech Preview Agreement.

The development, release and timing of any features or functionality described in the Preview documentation remains at our sole discretion and are subject to change without notice or consultation.

The documentation is for informational purposes only and is not a commitment, promise or legal obligation to deliver any material, code or functionality and should not be relied upon in making Cloud Software Group product purchase decisions.

If you do not agree, select I DO NOT AGREE to exit.