Configuration du clustering de couche 3

Comprendre le cluster L3

La demande visant à étendre le déploiement de la haute disponibilité et à accroître l’évolutivité du trafic client sur différents réseaux a guidé la mise en place du cluster L3. Le cluster L3 vous permet de regrouper les appliances NetScaler sur des sous-réseaux individuels (cluster L2).

Le cluster L3 est également appelé « cluster en mode de configuration réseau indépendante (INC) ». Dans le déploiement d’un cluster L3, les nœuds du cluster d’un même réseau sont regroupés pour former un groupe de nœuds. Le cluster L3 utilise le tunneling GRE pour diriger les paquets sur les réseaux. Les messages de pulsation à travers les clusters L3 sont routés.

Architecture

L’architecture du cluster L3 comprend les composants suivants :

-

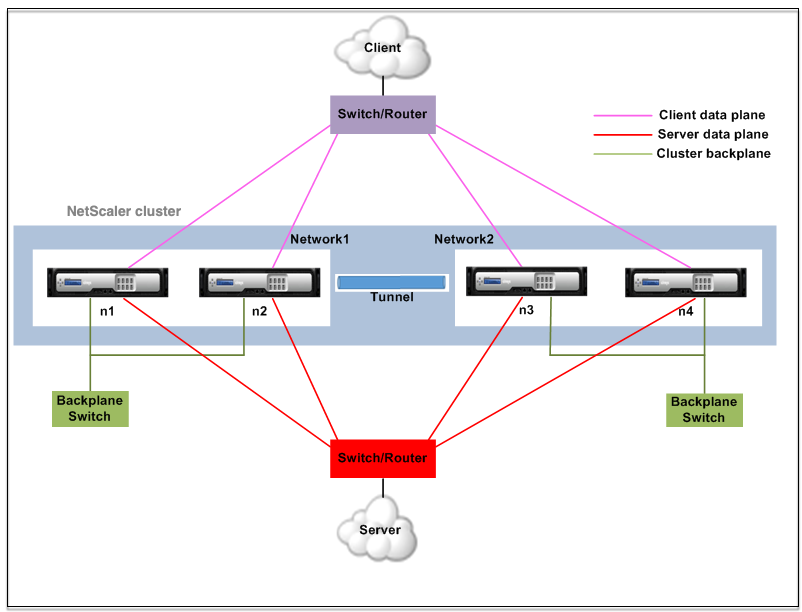

Groupe de nœuds : les nœuds de cluster de chaque réseau (n1, n2) et (n3, n4), comme illustré dans la figure suivante, sont regroupés pour former un groupe de nœuds. Ces groupes de nœuds sont reliés au commutateur de couche 3 de chaque côté du réseau.

- Le cluster communique avec le client via les connexions physiques entre le nœud de cluster et le périphérique de connexion côté client. Le regroupement logique de ces connexions physiques est appelé plan de données client.

- Le cluster communique avec le serveur via les connexions physiques entre le nœud du cluster et le périphérique de connexion côté serveur. Le groupement logique de ces connexions physiques est appelé plan de données du serveur.

- Commutateur de backplane : les nœuds du cluster d’un même réseau communiquent entre eux à l’aide du backplane du cluster. Le backplane est un ensemble d’interfaces dans lequel une interface de chaque nœud est connectée à un commutateur commun, appelé commutateur de fond de cluster.

-

Tunnel : par défaut, les paquets entre les nœuds d’un cluster L3 sont échangés via un tunnel GRE non chiffré qui utilise les adresses NSIP des nœuds source et de destination pour le routage. Le mécanisme de pilotage change pour les nœuds appartenant aux différents réseaux. Les paquets sont dirigés via un tunnel GRE vers le nœud de l’autre sous-réseau, au lieu de réécrire le MAC.

Remarque :

Pour un nouveau déploiement, nous vous recommandons d’utiliser le tunnel UDP pour diriger les paquets sur les réseaux. Les avantages de l’utilisation d’un tunnel UDP sont les suivants :

- Le pilotage entre les moteurs de paquets est basé sur 4 tuples, ce qui permet une meilleure distribution.

- Vous pouvez éviter l’asymétrie dans l’utilisation du processeur.

Reportez-vous au tableau suivant pour comprendre comment les paquets sont dirigés dans les différents modes de tunnel.

Mode tunnel Même réseau Réseau différent Aucun Le backplane est utilisé pour diriger les paquets. Le tunnel GRE est utilisé pour diriger le trafic. GRE Le tunnel GRE est utilisé pour diriger les paquets. Le tunnel GRE est utilisé pour diriger les paquets. UDP Le tunnel UDP est utilisé pour diriger les paquets. Le tunnel UDP est utilisé pour diriger les paquets.

Exemple

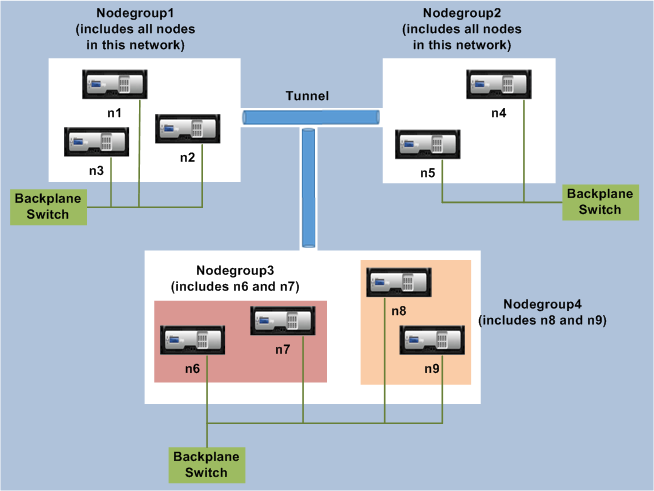

Prenons un exemple de déploiement de cluster L3 comprenant les éléments suivants :

- Trois nœuds des appliances NetScaler (n1, n2 et n3) sont regroupés dans Nodegroup1.

- De même, les nœuds n4 et n5 sont regroupés dans Nodegroup2. Dans le troisième réseau, il existe deux groupes de nœuds. Nodegroup3 inclut n6 et n7 et Nodegroup4 inclut n8 et n9.

- Les appliances NetScaler qui appartiennent au même réseau sont combinées pour former un groupe de nœuds.

Points à prendre en compte avant de configurer le cluster L3

Tenez compte des points suivants avant de configurer le cluster L3 sur une appliance NetScaler :

- Le backplane n’est pas obligatoire lors de la configuration des sous-réseaux L3. Si le fond de panier n’est pas spécifié, le nœud ne passe pas à l’état d’échec du fond de panier.

Remarque :

Si vous avez plusieurs nœuds dans le même réseau L2, il est obligatoire de définir l’interface du fond de panier. Si l’interface du fond de panier n’est pas mentionnée, les nœuds passent à l’état d’échec du fond de panier.

-

Les fonctionnalités L2 et les SNIP entrelacés ne sont pas pris en charge dans le cluster L3.

- La distribution du trafic externe dans le cluster L3 prend uniquement en charge le protocole ECMP (Equal Cost Multiple Path).

- Les erreurs et la fragmentation ICMP ne sont pas traitées lorsque le pilotage est désactivé dans un déploiement de cluster L3 :

- Les entités réseau (

route, route6, pbr, etpbr6) doivent être liées au groupe de nœuds de configuration. - Le VLAN, le RNAT et le tunnel IP ne peuvent pas être liés à un groupe de nœuds de configuration.

- Le groupe de nœuds de configuration doit toujours avoir la propriété STRICT « YES ».

- Les nœuds de cluster ne doivent pas être ajoutés à un groupe de nœuds de configuration via la commande « ajouter un nœud de cluster ».

- La commande

add cluster instance -INC enabledefface les entités réseau (route, route6, PBR, pb6, RNAT, tunnel IP, ip6tunnel). - La commande

clear config extended+ne prend pas en charge les entités (route, route6, PBR, pb6, RNAT, tunnel IP, ip6tunnel) dans un cluster L3.

Configuration du cluster L3

Dans une configuration de cluster L3, la commande cluster a différents attributs à configurer qui sont basés sur les nœuds et les groupes de nœuds. La configuration du cluster L3 inclut également un profil IPv6 en dehors des profils IPv4.

La configuration d’un cluster L3 sur une appliance NetScaler comprend les tâches suivantes :

- Créer une instance de cluster

- Création d’un groupe de nœuds dans un cluster L3

- Ajouter une appliance NetScaler au cluster et au groupe avec le groupe de nœuds

- Ajouter l’adresse IP du cluster au nœud

- Activer l’instance de cluster

- Enregistrez la configuration

- Ajouter un nœud à un groupe de nœuds existant

- Création d’un groupe de nœuds dans un cluster L3

- Regroupez les nouveaux nœuds dans le groupe de nœuds nouvellement créé

- Joindre le nœud au cluster

Configuration des éléments suivants à l’aide de l’interface de ligne de commande

-

Pour créer une instance de cluster

add cluster instance <clid> -inc <ENABLED|DISABLED> -processLocal <ENABLED|DISABLED>Remarque :

Le paramètre « inc » doit être ACTIVÉ pour un cluster L3.

-

Pour créer un groupe de nœuds dans un cluster L3

add cluster nodegroup <name> -

Pour ajouter une appliance NetScaler au cluster et l’associer à nodegroup

add cluster node <nodeid> <nodeip> -backplane <interface_name> nodegroup <ng> –tunnelmode UDP -

Pour ajouter l’adresse IP du cluster sur ce nœud

add ns ip <IPAddress> <netmask> -type clip -

Activer l’instance de cluster

enable cluster instance <clId> -

Enregistrez la configuration

save ns config -

Redémarrage à chaud de l’appliance

reboot -warm -

Pour ajouter un nouveau nœud à un groupe de nœuds existant

add cluster node <nodeid> <nodeip> -nodegroup <ng> –tunnelmode UDP -

Pour créer un nouveau groupe de nœuds dans un cluster L3

add cluster nodegroup <ng> -

Pour regrouper de nouveaux nœuds dans le groupe de nœuds nouvellement créé

add cluster node <nodeid> <nodeip> -nodegroup <ng> –tunnelmode UDP -

Pour joindre le nœud au cluster

join cluster –clip <ip_addr> -password <password>

Example: The following is an example configuration for nodegroup1 and nodegroup2.

> add cluster instance 1 –inc ENABLED –processLocal ENABLED

Done

> add cluster nodegroup ng1

Done

> add cluster node 0 1.1.1.1 –state ACTIVE -backplane 0/1/1 –nodegroup ng1 –tunnelmode UDP

Done

> add ns ip 1.1.1.100 255.255.255.255 –type clip

Done

> enable cluster instance 1

Done

> save ns config

Done

> add cluster node 1 1.1.1.2 –state ACTIVE –nodegroup ng1 –tunnelmode UDP

Done

> add cluster nodegroup ng2

Done

> add cluster node 4 2.2.2.1 –state ACTIVE –nodegroup ng2 –tunnelmode UDP

Done

> add cluster node 5 2.2.2.2 –state ACTIVE –nodegroup ng2 –tunnelmode UDP

Done

> join cluster -clip 1.1.1.100 -password nsroot

<!--NeedCopy-->

Adresse IP du cluster de publicité d’un cluster L3

Configurez l’adresse IP du cluster à annoncer au routeur en amont afin de rendre la configuration du cluster accessible depuis n’importe quel sous-réseau. L’adresse IP du cluster est annoncée en tant que route du noyau par les protocoles de routage dynamique configurés sur un nœud.

La publicité de l’adresse IP du cluster comprend les tâches suivantes :

- Activez l’option de route hôte de l’adresse IP du cluster. L’option de route hôte transmet l’adresse IP du cluster à une table de routage ZebOS pour la redistribution des routes du noyau via des protocoles de routage dynamiques.

- Configuration d’un protocole de routage dynamique sur un nœud.Un protocole de routage dynamique annonce l’adresse IP du cluster au routeur amont. Pour plus d’informations sur la configuration d’un protocole de routage dynamique, voirConfiguration des routes dynamiques.

Pour activer l’option de routage hôte de l’adresse IP du cluster à l’aide de l’interface de ligne de commande

À l’invite de commande, tapez :

add nsip <IPAddress> <netmask> -hostRoute ENABLEDshow nsip <IPAddress>

> add ns ip 10.102.29.60 255.255.255.255 -hostRoute ENABLED

> Done

<!--NeedCopy-->

Configurations repérées et partiellement réparties sur un cluster L3

Les configurations à points et partiellement entrelacés du cluster L3 diffèrent légèrement de celles du cluster L2. La configuration peut différer d’un nœud à l’autre, car les nœuds résident sur des sous-réseaux différents. Les configurations réseau peuvent être spécifiques aux nœuds du cluster L3. Vous devez donc configurer les configurations repérées ou partiellement réparties en fonction des paramètres mentionnés ci-dessous.

Pour configurer des configurations repérées partiellement réparties par bandes sur une appliance NetScaler via le cluster L3, effectuez les tâches suivantes :

- Ajouter un groupe propriétaire de cluster à une table de routage statique IPv4

- Ajouter un groupe propriétaire de cluster à une table de routage statique IPv6

- Ajouter un groupe propriétaire de cluster à un routage IPv4 basé sur des stratégies (PBR)

- Ajouter un groupe propriétaire de cluster à un PBR IPv6

- Ajouter un VLAN

- Lier un VLAN à un groupe de propriétaires ou à un groupe de nœuds de cluster spécifique

Configuration des éléments suivants à l’aide de l’interface de ligne de commande

-

Pour ajouter un groupe propriétaire de cluster à une table de routage statique IPv4 de l’appliance NetScaler

add route <network> <netmask> <gateway> -owner group <ng> -

Pour ajouter un groupe propriétaire de cluster à une table de routage statique IPv6 de l’appliance NetScaler

add route6 <network> -owner group <ng> -

Pour ajouter un groupe-propriétaire de cluster à un PBR IPv4

add pbr <name> <action> -owner group <ng> -

Pour ajouter un groupe-propriétaire de cluster à un PBR IPv6

add pbr6 <name> <action> -owner group <ng> -

Pour ajouter un VLAN

add vlan <id> -

Pour lier un VLAN à un propriétaire/groupe de nœuds de cluster spécifique

bind vlan <id> -ifnum – [IPAddress <ipv4_addr | ipv6_addr> [-owner group <ng>]Les commandes suivantes sont des exemples de configurations ponctuelles et partiellement entrelacées qui peuvent être configurées à l’aide de l’interface de ligne de commande.

> add route 10.102.29.0 255.255.255.0 10.102.29.2 –ownergroup ng2

Done

> add route6 fe80::9404:60ff:fedd:a464/64 –ownergroup ng1

Done

> add pbr pbr1 allow –ownergroup ng1

Done

> add pbr6 pbr2 allow –ownergroup ng2

Done

> add vlan 2

Done

> bind vlan 2 –ifnum 1/2 –[IPAddress 10.102.29.80 | fe80::9404:60ff:fedd:a464/64-ownergroup ng1

Done

<!--NeedCopy-->

Configurer le groupe de nœuds

Dans un cluster L3, pour répliquer le même ensemble de configurations sur plusieurs groupes de nœuds, les commandes suivantes sont utilisées :

Configuration des éléments suivants à l’aide de l’interface de ligne de commande

-

Pour ajouter une route statique IPv4 à la table de routage de l’appliance NetScaler

add route <network> <netmask> <gateway> -ownerGroup <ng>

Exemple de configuration :

add route 0 0 10.102.53.1 –ownerGroup ng1

add route 0 0 10.102.53.1 –ownerGroup ng2

<!--NeedCopy-->

Vous définissez un nouveau groupe de nœuds « tous » pour prendre en charge la configuration précédente, et vous devez configurer les commandes suivantes :

Configuration des éléments suivants à l’aide de l’interface de ligne de commande

-

Pour ajouter un nouveau groupe de nœuds au cluster avec un paramètre strict

add cluster node group <name> -strict <YES | NO> -

Pour lier un nœud de cluster ou une entité au groupe de nœuds donné

bind cluster nodegroup <name> -node <nodeid> -

Pour ajouter une route statique IPv4 à tous les groupes de propriétaires

add route <network> <netmask> <gateway> -ownerGroup <ng>

Exemple de configuration :

add cluster nodegroup all –strict YES

bind cluster nodegroup all –node 1

bind cluster nodegroup all –node 2

add route 0 0 10.102.53.1 –ownerGroup all

<!--NeedCopy-->

Distribution du trafic dans un cluster L3

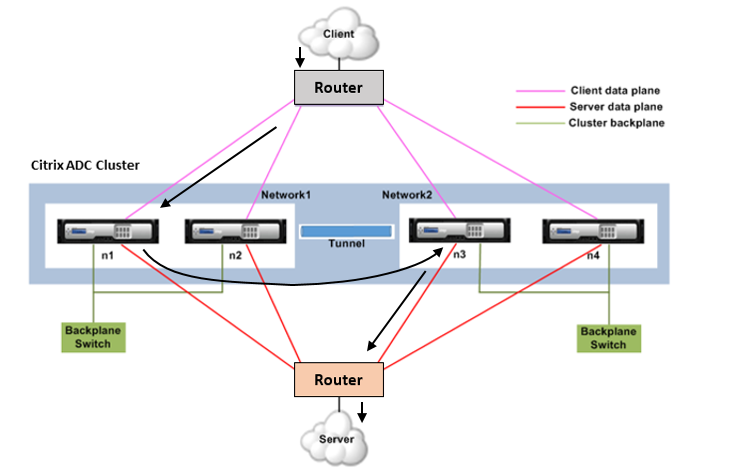

Dans une configuration en cluster, les réseaux externes considèrent l’ensemble des appliances NetScaler comme une entité unique. Ainsi, le cluster doit sélectionner un nœud unique qui doit recevoir le trafic. Dans le cluster L3, cette sélection est effectuée à l’aide de l’ECMP. Le nœud sélectionné est appelé récepteur de flux.

Remarque

Pour un cluster L3 (nœuds répartis sur différents réseaux), seule la distribution du trafic ECMP peut être utilisée.

Le récepteur de flux reçoit le trafic puis, à l’aide de la logique de cluster interne, détermine le nœud qui doit traiter le trafic. Ce nœud est appelé processeur de flux. Le récepteur de flux oriente le trafic vers le processeur de flux via le fond de panier si le récepteur de flux et le processeur de flux se trouvent sur le même réseau. Le trafic est dirigé à travers le tunnel si le récepteur de débit et le processeur de débit se trouvent sur des réseaux différents.

Remarque

Le récepteur de flux et le processeur de flux doivent être des nœuds capables de traiter le trafic.

À partir de NetScaler 11, vous pouvez désactiver la direction sur le backplane du cluster. Pour plus d’informations, voir Désactivation du pilotage sur le fond de panier du cluster.

La figure précédente montre une demande client qui traverse le cluster. Le client envoie une demande à une adresse IP virtuelle (VIP). Un mécanisme de distribution du trafic configuré sur le plan de données client sélectionne l’un des nœuds du cluster comme récepteur de flux. Le récepteur de flux reçoit le trafic, détermine le nœud qui doit traiter le trafic et dirige la demande vers ce nœud (à moins que le récepteur de flux ne se sélectionne lui-même comme processeur de flux). Si le processeur de flux et le récepteur de flux se trouvent dans le même groupe de nœuds, le paquet est dirigé sur le fond de panier. Et si le processeur de flux et le récepteur de flux se trouvent dans des groupes de nœuds différents, le paquet est dirigé à travers le tunnel sur le chemin routé.

Le processeur de flux établit une connexion avec le serveur. Le serveur traite la demande et envoie la réponse à l’adresse IP du sous-réseau (SNIP) qui a envoyé la demande au serveur. Étant donné que dans le cluster L3, le SNIP est toujours un SNIP repéré, le nœud propriétaire de l’adresse SNIP reçoit la réponse du serveur.