ノード間通信の設定

クラスタセットアップ内のノードは、次のノード間通信メカニズムを使用して相互に通信します。

- ネットワーク(同じサブネット)にあるノードは、クラスタバックプレーンを介して相互に通信します。バックプレーンは明示的に設定する必要があります。詳細な手順は次のとおりです。

- ネットワーク全体では、パケットのステアリングはGREトンネルを介して行われ、その他のノード間通信は必要に応じてノード間でルーティングされます。

重要:

- リリース11.0以降、すべてのビルドで、クラスタに異なるネットワークのノードを含めることができます。

- リリース 13.0 ビルド 58.3 以降、GRE ステアリングは L3 クラスタのフォートビル NIC でサポートされています。

クラスタバックプレーンをセットアップするには、ノードごとに次の操作を行います

- バックプレーンに使用するネットワークインターフェイスを特定してください。

- 選択したネットワークインターフェイスからクラスタバックプレーンスイッチに Ethernet ケーブルまたは光ケーブルを接続します。

たとえば、ノード 4 のバックプレーンインターフェイスとしてインターフェイス 1/2 を使用するには、ノード 4 の 1/2 インターフェイスからバックプレーンスイッチにケーブルを接続します。

クラスタバックプレーンをセットアップする際の注意点

-

アプライアンスの管理インターフェイス(0/x)をバックプレーンインターフェイスとして使用しないでください。クラスタでは、インターフェイス 0/1/x は次のように読み込まれます:

0 -> ノード ID 0 1/x-> NetScaler インターフェイス

-

クライアントまたはサーバのデータプレーンには、バックプレーンインターフェイスを使用しないでください。

- クラスタバックプレーンには、リンク集約(LA)チャネルを使用することをお勧めします。

注:

LA チャネルからインターフェイスをバインド解除したら、バインドされていないインターフェイスに適切な MTU サイズを設定してください。

-

バックプレーンがバックツーバック接続されている 2 ノードクラスタでは、次のいずれかの条件下で、クラスタは動作上 DOWN になります:

- ノードの 1 つが再起動されます。

- いずれかのノードのバックプレーンインターフェースが無効になっています。

そのため、Citrixでは、他のクラスタノードやトラフィックに影響を与えないように、バックプレーン専用のスイッチを用意することを推奨しています。バックツーバックリンクでクラスターをスケールアウトすることはできません。クラスターノードをスケールアウトすると、本番環境でダウンタイムが発生する可能性があります。

-

クラスタのすべてのノードのバックプレーンインターフェイスは、同じスイッチに接続され、同じ L2 VLAN にバインドされている必要があります。

-

同じクラスタインスタンス ID を持つクラスタが複数ある場合は、各クラスタのバックプレーンインターフェイスが異なる VLAN にバインドされていることを確認してください。

-

バックプレーンインターフェイスは、そのインターフェイスの HA モニタリング設定に関係なく、常に監視されます。

-

さまざまな仮想化プラットフォームでの MAC スプーフィングの状態は、クラスタバックプレーンのステアリングメカニズムに影響を与える可能性があります。そのため、適切な状態が設定されていることを確認してください。

- XenServer-MAC スプーフィングを無効にする

- Hyper-V-MAC スプーフィングを有効にする

- VMware ESX-MAC スプーフィングを有効にする(「偽造送信」が有効になっていることも確認する)

-

クラスタバックプレーンの MTU は自動的に更新されます。ただし、クラスタでジャンボフレームを設定する場合は、クラスタバックプレーンの MTU を明示的に設定する必要があります。値は 78 + X に設定する必要があります。X はクライアントとサーバのデータプレーンの最大 MTU です。たとえば、サーバデータプレーンの MTU が 7500 で、クライアントデータプレーンの MTU が 8922 だとします。クラスタバックプレーンの MTU は 78 + 8922 = 9000 に設定する必要があります。この MTU を設定するには、次のコマンドを使用します。

> set interface <backplane_interface> -mtu <value> -

バックプレーンスイッチのインターフェイスの MTU は、1,578 バイト以上で指定する必要があります。クラスタに MBF、L2 ポリシー、ACL、CLAG 環境でのルーティング、VPath などの機能がある場合に適用できます。

注:

バックプレーンインターフェイスのデフォルトの MTU サイズは 1578 です。MTU サイズをデフォルト値にリセットするには、

unset interface <backplane_interface> -mtuコマンドを使用する必要があります。

L2 および L3 クラスタの UDP ベースのトンネルサポート

NetScalerリリース13.0ビルド36.x以降、NetScaler L2およびL3クラスターはUDPベースのトンネリングを使用してトラフィックを誘導できるようになりました。クラスタ内の 2 つのノードのノード間通信用に定義されています。「トンネルモード」パラメータを使用すると、クラスタノードを追加および設定するコマンドから GRE または UDP トンネルモードを設定できます。

L3クラスター展開では、NetScalerノード間のパケットは、送信元ノードと宛先ノードのNSIPアドレスを使用してルーティングされる暗号化されていないGREトンネルを介して交換されます。この交換がインターネット上で行われる場合、IPsec トンネルがないと NSIP がインターネット上に公開され、セキュリティ上の問題が発生する可能性があります。

重要:

Citrix では、L3クラスタを使用する場合は独自のIPsecソリューションを確立することをお客様に推奨しています。

次の表は、さまざまな展開に基づいてトンネルサポートを分類するのに役立ちます。

| ステアリングタイプ | AWS | Microsoft Azure | オンプレミス |

|---|---|---|---|

| MAC | 未サポート | 未サポート | サポート対象 |

| GRE トンネル | サポート対象 | 未サポート | サポート対象 |

| UDP トンネル | サポート対象 | サポート対象 | サポート対象 |

重要:

L3 クラスタでは、トンネルモードはデフォルトで GRE に設定されます。

UDP ベースのトンネルの設定

ノード ID のパラメータを設定して状態を記述することで、クラスタノードを追加できます。インターフェイス名を指定してバックプレーンを設定し、任意のトンネルモード (GRE または UDP) を選択します。

注:

クラスタ IP アドレスからトンネルモードを設定する必要があります。

CLI のプロシージャ

CLI を使用して UDP トンネルモードを有効にします。

コマンドプロンプトで入力します:

add cluster node <nodeId>@ [-state <state>] [-backplane <interface_name>] [-tunnelmode <tunnelmode>]set cluster node <nodeId>@ [-state <state>] [-tunnelmode <tunnelmode>]

注:

トンネルモードに設定できる値は、NONE、GRE、UDP です。

例

add cluster node 1 –state ACTIVE –backplane 1/1/1 -tunnelmode UDPset cluster node 1 –state ACTIVE –tunnelmode UDP

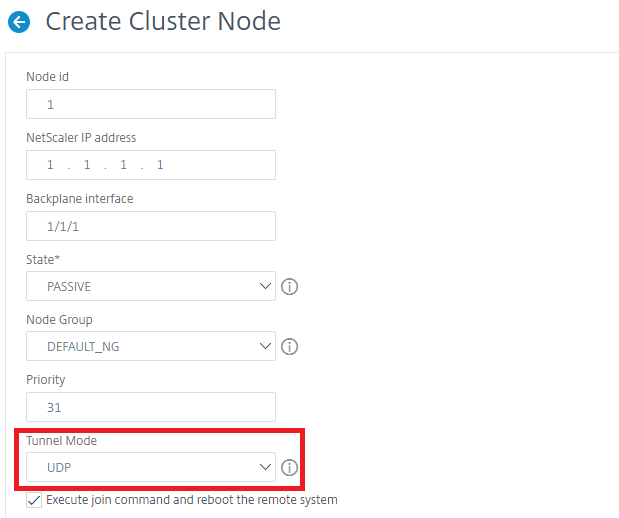

GUIのプロシージャ

GUI を使用して UDP トンネルモードを有効にします。

-

[ システム] > [クラスタ] > [ノード] に移動します。

-

「 クラスターノード 」ページで、「 追加」をクリックします。

-

「 クラスターノードの作成」で、「 トンネルモード 」パラメーターを UDP に設定し、「 作成」をクリックします。

-

[閉じる] をクリックします。